삼성SDS는 대형 언어 모델(LLM)의 추론 속도를 최대 48.3% 향상시키고, 전력 소모를 11.5% 절감하는 새로운 AI 시스템 ‘PAISE’를 개발했습니다. 핵심은 메모리 안에서 직접 계산을 수행하는 PIM(Processing-In-Memory) 기술. 이 글에서는 PAISE가 어떻게 기존 AI 병목을 해결하고, 지속 가능한 AI 인프라를 가능케 했는지 소개합니다.

PAISE: PIM-Accelerated Inference Scheduling Engine for Transformer-based LLM

👉 논문 바로가기

왜 AI 속도가 느린 걸까? – 어텐션의 병목 문제

요즘 인공지능 서비스의 중심에는 대형 언어 모델(LLM)이 있습니다. ChatGPT나 Claude 같은 모델은 사람처럼 자연스러운 대화를 가능하게 하지만, 이런 성능 뒤에는 어마어마한 계산량과 메모리 사용이 숨어 있습니다. 특히 모델이 문장을 생성하는 과정에서는 ‘어텐션’이라는 구조가 매번 이전 단어들을 참조해 새 단어를 만들어내는데, 이 과정이 성능을 크게 좌우합니다.

왜 어텐션이 문제일까요? 어텐션은 현재 단어를 생성할 때, 앞서 생성된 모든 단어와의 연관성을 계산합니다. 이때 Query, Key, Value라는 세 종류의 벡터가 만들어지고, 그중 Key와 Value는 계속해서 저장되고 불러와야 합니다. 한 단어를 만들 때마다 이 저장된 값 전체를 다시 읽고 새로운 데이터를 추가해야 하므로, 시간이 갈수록 데이터의 양이 기하급수적으로 늘어납니다. 연산 자체보다도 ‘데이터를 메모리에서 읽고 쓰는’ 과정이 모델 속도를 결정하는 병목이 되는 이유입니다.

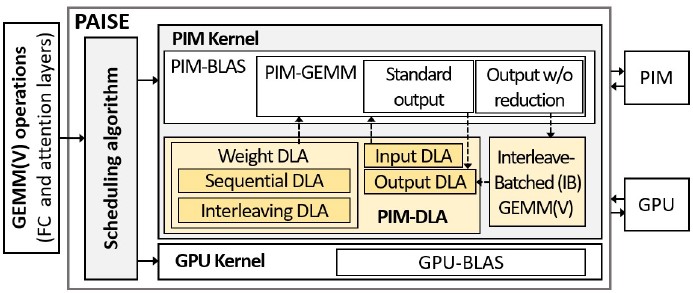

[그림1] PAISE의 구성요소 (스케줄링 알고리즘, PIM-DLA, IB-GEMM(V))

[그림1] PAISE의 구성요소 (스케줄링 알고리즘, PIM-DLA, IB-GEMM(V))

삼성SDS의 접근: 메모리 안에서 계산하는 새로운 방식인 PAISE

삼성 SDS 클라우드연구팀은 이러한 한계를 극복하기 위해 PAISE(PIM-Accelerated Inference Scheduling Engine, IEEE HPCA 2025 발표) 라는 새로운 시스템을 제안했습니다. 이 시스템은 ‘PIM(Processing-In-Memory)’이라는 기술을 활용합니다. PIM은 기존처럼 CPU나 GPU에서만 계산하지 않고, 메모리 칩 안에 계산 장치를 넣어 데이터를 이동하지 않고 바로 처리하는 기술입니다. 데이터를 자주 읽고 써야 하는 어텐션 같은 연산에 특히 적합하죠.

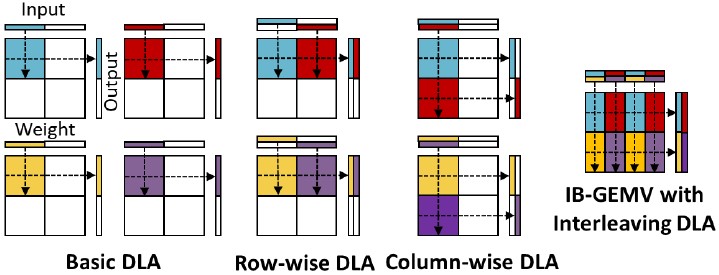

[그림 2] PAISE의 데이터 정렬 최적화 기법 (PIM-DLA)

[그림 2] PAISE의 데이터 정렬 최적화 기법 (PIM-DLA)

PIM-DLA: 더 나은 메모리 정렬 방식

하지만 PIM이 있다고 무조건 빠른 것은 아닙니다. 어떤 계산을 PIM에서 처리해야 효율적인지 똑똑하게 판단하고, PIM 내부 구조에 맞춰 데이터를 배열하는 정교한 기술이 필요합니다. PAISE는 바로 이 문제를 해결합니다. 첫째, 각 연산의 특성과 하드웨어 구조를 분석해 어떤 연산을 PIM으로 보내는 것이 좋은지 자동으로 결정합니다(스케줄링 알고리즘). 둘째, 메모리 안에서 계산이 더 빠르게 이뤄지도록 데이터를 정렬하고 나누는 최적화 기법(PIM-DLA, Data Layout Adjustment)도 함께 적용합니다.

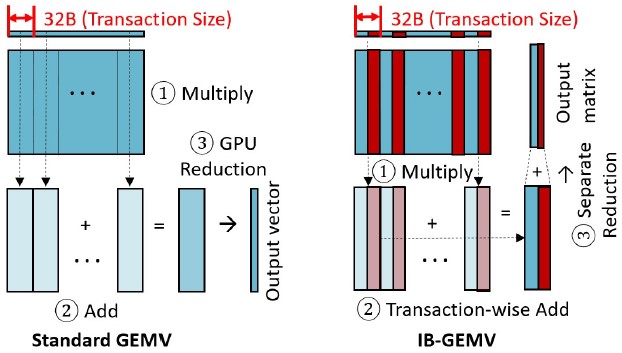

[그림3] PAISE의 새로운 행렬 연산 기법 (IB-GEMV)

[그림3] PAISE의 새로운 행렬 연산 기법 (IB-GEMV)

IB-GEMV: 병렬화된 어텐션 연산

그리고 연구팀은 어텐션 연산을 더욱 효율적으로 처리하기 위해 IB-GEMV(Interleave-Batched General Matrix-Vector Multiplication) 라는 방식도 함께 도입했습니다. 일반적으로 모델은 작은 행렬 곱셈을 반복해서 수행하지만, 이 연산들을 하나하나 처리하면 병렬화가 어렵고 속도가 느려집니다. IB-GEMV는 이러한 작은 연산들을 메모리 안에서 미리 섞어 배치(interleave)해 한 번에 처리할 수 있도록 해줍니다. 즉, 다양한 연산을 한 덩어리로 묶어 병렬로 실행하고, 계산 결과도 효과적으로 나눠 저장할 수 있어 메모리 대역폭을 극대화할 수 있습니다.

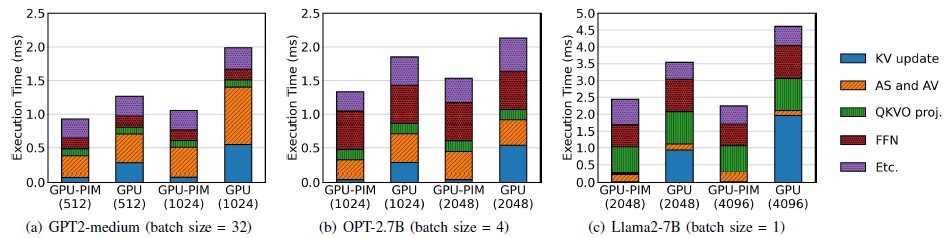

[그림4] LLM 추론 단계 별 PAISE 적용 후 (GPU-PIM) 실행 시간 감소

[그림4] LLM 추론 단계 별 PAISE 적용 후 (GPU-PIM) 실행 시간 감소

실험 결과 - 속도는 최대 48%, 전력은 11% 절감

실제로 연구팀은 GPT-2, OPT, Llama2 모델에 이 기술을 적용해 실험했습니다. 그림 4에 따르면, IB-GEMV 방식은 특히 배치 크기가 클수록 성능 이점이 뚜렷하게 나타나며, 작은 배치에도 효율을 유지합니다. 특히 어텐션 레이어에서 반복적으로 발생하는 Key-Value(KV) 캐시 업데이트 시간이 크게 줄어든 것이 주요한 개선 요인 중 하나입니다. 이는 IB-GEMV 방식이 연산 구조에 따라 유연하게 동작하며, LLM 추론의 다양한 상황에 적응할 수 있음을 시각적으로 잘 보여줍니다. PAISE는 GPU에만 의존하던 기존 구조에서 벗어나, PIM을 활용해 메모리 바운드 병목을 해소함으로써 LLM 추론 성능을 실질적으로 향상시킨 효과적인 시스템으로 평가됩니다.

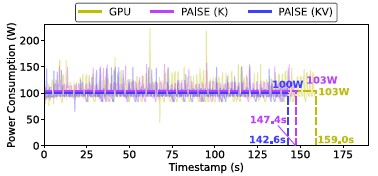

[그림5] PAISE 적용 후 전력 소모 감소

[그림5] PAISE 적용 후 전력 소모 감소

더불어, PAISE를 활용했을 때 최대 48.3%까지 추론 속도가 빨라졌고, 전력 소모도 약 11.5% 줄어드는 효과를 얻었습니다. 그림 5는 PIM을 활용했을 때 GPU 전체 시스템의 평균 전력 소비가 낮아졌으며, 실행 시간도 단축되어 총 에너지 사용량까지 줄어들었음을 보여줍니다. 이는 단순한 속도 개선을 넘어, 지속 가능한 AI 인프라 운영에 실질적인 도움이 되는 기술임을 시사합니다.

본 연구의 의의와 미래방향

마지막으로, GPU 기존의 많은 연구들이 시뮬레이션으로만 성능을 분석한 데 반해, PAISE는 삼성의 실제 PIM 하드웨어인 ‘Aquabolt-XL’을 기반으로 구현되고 검증되었다는 점에서도 큰 의의가 있습니다. PAISE는 단순히 빠른 AI를 만드는 것에 그치지 않고, 전력 소모를 줄이고 인프라 비용을 절감하는 데에도 기여할 수 있습니다. 앞으로 PAISE가 더 발전하면, 다양한 인공지능 서비스가 훨씬 더 빠르고 경제적으로 제공될 수 있을 것입니다. 메모리 안에서 직접 계산하는 이 혁신적인 접근은, AI의 미래를 다시 한 번 앞당기고 있습니다.

👉 논문 바로가기