여러분은 차량을 구입할 때 어떤 성능을 중요하게 여기시나요? 몇 년 전만 하더라도 휘발유 엔진이냐, 경유 엔진이냐가 차량을 나누는 기준이었습니다. 그런데 자율주행과 전기차 기술이 많이 상용화된 요즘은 어떤가요? 연료보다는 ADAS, 즉 Advanced Driver Assistance Systems(고성능 운전 보조 시스템)이 차량 선택에 있어서 중요한 고려 사항이 되고 있습니다. 많은 소비자들이 운전자의 편의성을 높이면서도 안전성이 보장된 차량을 선호하고 있기 때문이죠.

ADAS가 운전자를 보조하는 기능에는 여러 가지가 있겠지만, 그 중 자율주행은 ADAS의 꽃이라고 할 수 있는데요. 운전자의 개입 없이도 차량이 스스로 운행한다는 점에서 진정한 의미의 ‘자동차(自動車)’를 구현하는 것이기도 하죠. 모빌리티의 미래인 자율주행을 가능하도록 만드는 원리에는 어떤 것이 있을까요? 이번 인사이트 리포트에서는 자율주행을 가능케 하는 핵심 기술들에 대해 알아보겠습니다.

목차

자율주행이란?

자율주행은 인간의 개입 없이 차량이 스스로 주변 환경을 인식, 판단, 제어하여 목적지까지 안전하게 운행할 수 있는 기술을 말합니다. 이 기술은 센서를 통해 주변 환경을 감지하고, 인공지능 알고리즘으로 상황을 판단하며, 정밀한 제어 시스템으로 차량을 조작합니다. 앞으로 자율주행 기술이 더욱 고도화되고 보급률이 높아지면, 교통사고 감소, 교통 효율성 증가, 이동성 향상 등 많은 이점이 생길 것으로 기대됩니다.

자율주행을 가능하게 하는 기술은 시각 정보 습득, 위치 정보 파악, 주변 환경과의 통신 세 가지 범주로 나뉘어집니다.

자율주행의 핵심 기술들

- 시각 정보 습득 : 라이다(LiDAR), 테슬라 비전(Tesla Vision)

- 위치 정보 파악 : SLAM(Simultaneous Localization And Mapping) 알고리즘

- 주행 환경 및 정보 통신 : V2X(Vehicle-to-Everything) 기술

운전자의 눈 역할을 하다 – 라이다 & 테슬라 비전

먼저 사람이 운전하는 경우를 떠올려 볼까요? 운전자는 도로 주변에 무엇이 있는지 시각으로 정보를 습득합니다. 앞 차와 자신의 거리를 파악해, 가까워지면 브레이크를 밟고 멀어지면 정해진 선에서 속도를 내죠. 즉 눈이 받아들이는 가시광선에 따라 사물을 인지하고 주행 정보를 파악하며, 운전에 대한 각종 결정을 내리게 됩니다.

자율주행 기술은 사람의 시각적 인지와 주행 판단 과정을 고스란히 닮았어요. 대표적인 기술로 라이다(LiDAR : Light Detection And Ranging)를 들 수 있습니다.

(1) 라이다(LiDAR : Light Detection And Ranging)

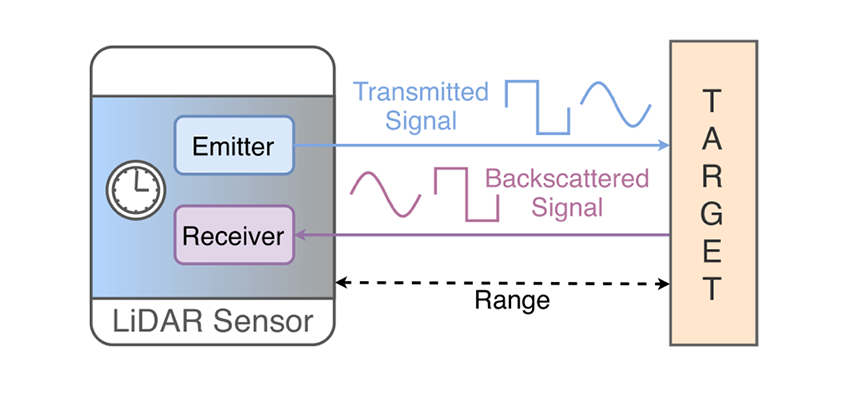

라이다는 자율주행을 가능케 하는 핵심 센서입니다. 라이다는 특정 기기에서 발사한 빛이 다른 물체에 부딪혀 돌아오는 현상을 이용하는데요. 아래 그림과 같이 라이다 기기 주변에 있는 물체에 닿은 빛이 반사되어 돌아오는 시간을 측정해 떨어진 거리를 측정하게 됩니다

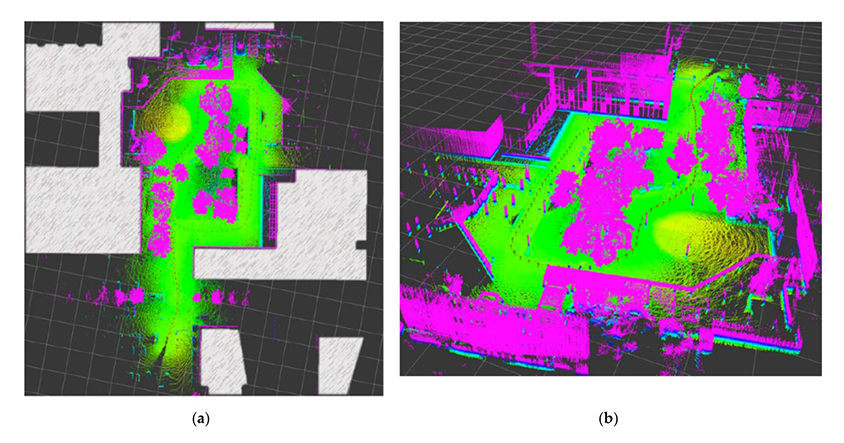

빛의 속도인 광속은 초당 299,792,458m입니다. 바로 이 정보를 이용해 레이저 펄스(Radar Pulse)의 형태로 라이다에서 발사된 빛이 돌아오는 시간을 측정하면 거리를 계산할 수 있게 되는 것입니다. 보통 라이다는 한 번만 빛을 발사하는 것이 아니라 초당 수백만 빛을 발사하며 이를 통해 3차원 공간을 시각화하게 됩니다. 이런 특성으로 인해 라이다는 자율주행 분야뿐 아니라 실내 지도 제작, 건축 등 다양한 분야에 활용됩니다.

그런데 실제로 라이다는 상당히 값비싼 장치로 여겨집니다. 라이다의 핵심 부품으로 인듐갈륨비소(InGaAs)로 된 반도체가 쓰이는데 이 소재가 고가이기 때문입니다. 따라서 보다 저렴한 실리콘 등의 소재로 라이다를 제작하려는 시도가 학계와 산업계에서 활발히 이뤄지고 있습니다.

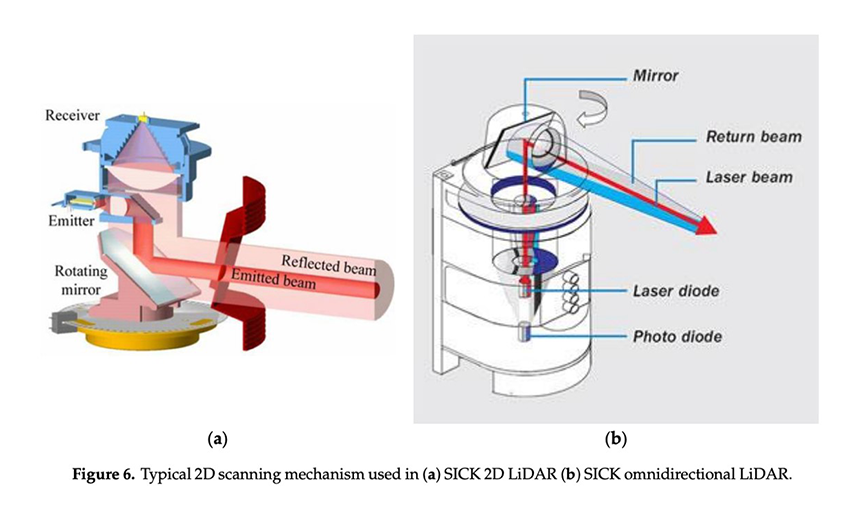

아래 그림은 라이다의 2차원 이미지 인식 메커니즘을 보여주고 있는데, 거울을 통해 다른 물체에서 반사되어 들어오는 빛이 리시버에 어떻게 도달하는지 잘 보여주고 있습니다.

(2) 테슬라 비전(Tesla Vision)

그럼 자율주행차 1위 제조사인 테슬라는 라이다에 대해 어떤 입장일까요? 잘 알려진 바와 같이 테슬라는 라이다에 대해 긍정적이지 않습니다. 테슬라 CEO 일론 머스크는 라이다에 대해 “doomed(운이 다하다, 비운을 맞다)”라며 부정적 평을 내놓은 적도 있습니다. 라이다나 레이더보다는 비전 기술의 성능에 우호적인데요. 이를 반영하듯, 테슬라는 라이다 대신 자신들만의 비전 시스템인 Tesla Vision을 상용화하기 위한 노력을 해오고 있습니다.

Tesla Vision은 Autopilot(오토파일럿), Enhanced Autopilot(강화된 오토파일럿), Full Self-Driving Capability(완전 자율주행) 등 테슬라의 3가지 자율주행 기술의 기반 역할을 합니다. 지난 10월 2일에는 테슬라 차량에 들어가는 Ultrasonic Sensor(초음파 센서)를 Tesla Vision으로 교체한다는 공식 발표를 내놓기도 했습니다.

Tesla Vision은 기본적으로 카메라 기반의 시스템입니다. 테슬라 차량에 여러 카메라를 달아 모든 방향의 시각 정보를 수집하고 이를 딥러닝 기술로 학습된 모델로 인식합니다. 차량 앞에 어떤 장애물이 있는지, 현재 도로의 상황은 어떤지, 사람이 눈으로 보듯 Tesla Vision이 예측 인지하게 됩니다.

따라서 Tesla Vision은 라이다 기술보다 저렴하지만 아무나 쉽게 따라 할 수 없습니다. 다량의 데이터가 있어야 모델을 훈련, 평가할 수 있고 실제 차량에 적용할 수 있기 때문이죠. Tesla Vision은 자율주행 시장 1위 사업자의 기술력과 데이터 수집력이 고스란히 들어가 있는 셈이며, 가격 경쟁력과 주행 성능을 동시에 높인다고 볼 수 있습니다.

나의 위치를 파악하다 – SLAM(Simultaneous Localization And Mapping) 알고리즘

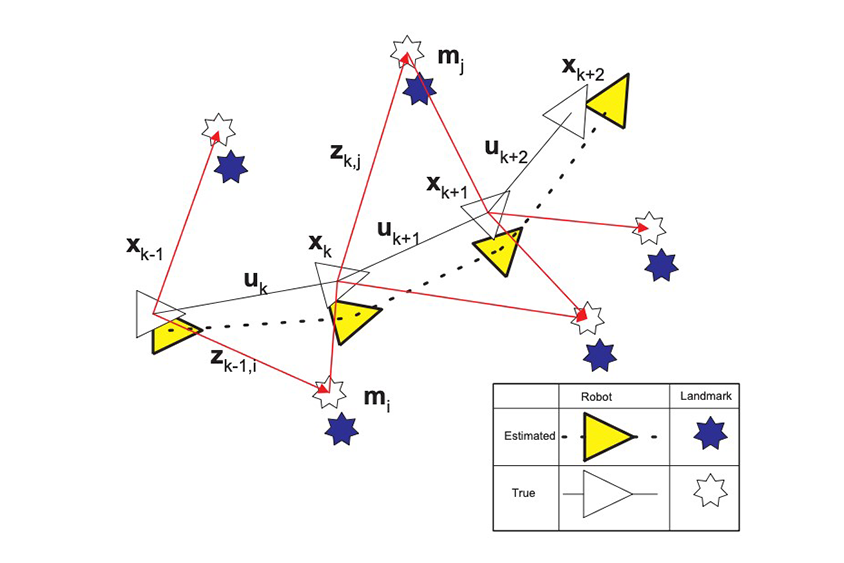

두 번째로 살펴볼 기술은 동시적 위치 추정과 지도 생성이라 불리는 SLAM(Simultaneous Localization And Mapping)입니다. SLAM은 미지의 환경에서 특정 객체가 센서를 활용해 자신의 위치 정보를 파악하면서 동시에 지도를 그려나가는 방법을 뜻합니다. 1986년 샌프란시스코에서 개최된 IEEE Robotics and Automation Conference에서 로봇의 자율주행을 위한 알고리즘으로 첫 제안되었습니다. 이후 실내외 및 해저 정보 파악을 위한 기본 알고리즘으로 연구되어 왔으며 자율주행 분야에서도 중요한 역할을 하고 있습니다.

SLAM은 여러 단계로 구성됩니다. 다음 그림은 SLAM의 기본 원리를 보여주는데, 먼저 자율주행 객체는 주변의 랜드마크를 참고해 자신의 위치와 주행 방향을 파악합니다. 이후 다음 단계로 나아가며 이 과정에서 비선형 주행의 상태 추정을 위한 Extended Kalman Filter 등의 알고리즘이 쓰입니다.

연산이 복잡해지는 Extended Kalman Filter의 문제점을 개선하기 위해 카메라로 생성된 이미지 정보를 활용하는 Visual SLAM, 그래프 정보와 최적화 문제 Graph-based SLAM, 수집된 이미지들의 광도가 만들어내는 차이를 활용한 Large-Scale Direct Monocular SLAM, 이미지의 RGB 값과 깊이(depth) 정보를 활용한 RGB-D SLAM 등이 있습니다.

Visual SLAM

: 카메라에서 획득한 시각 정보와 특징점을 추출하여 위치를 추정하고 환경 지도를 생성하는 기술로, 비용 효율적이지만 조명 변화에 민감함Graph-based SLAM

: 로봇의 이동 경로와 랜드마크를 노드로 표현한 그래프 구조를 최적화하여 정확한 위치와 지도를 생성하는 방식으로, 대규모 환경에서 정밀한 결과를 제공Large-Scale Direct Monocular SLAM

: 단일 카메라만으로 픽셀 단위 직접 비교를 통해 위치를 추정하고 대규모 환경을 매핑하는 기술로, 텍스처가 부족한 환경에서도 효과적임RGB-D SLAM

: 이미지와 깊이 센서 데이터를 결합하여 3차원 공간을 정확하게 복원하는 기술로, 실내 환경이나 정교한 근접 주행에 특히 유용함

근래의 자율주행 분야에서는 앞서 언급한 Visual SLAM, Graph-based SLAM과 함께 LiDAR 센서를 활용한 LIDAR-based SLAM, 차량에 부착된 여러 센서의 데이터를 복합적으로 사용하는 Multi-Sensor Fusion SLAM 등이 쓰이기도 합니다. LIDAR-based SLAM은 LiDAR 센서로 측정된 다른 물체와의 정밀한 거리 정보를 기반으로 지도를 생성하고 자신의 위치를 파악하게 됩니다. LIDAR-based SLAM은 광량이 풍부하지 않은 공간에서도 안정적으로 작동하므로 카메라 기반의 SLAM 방식보다 안정적이라는 장점이 있습니다. 또한 LiDAR는 물체로부터 반사된 빛의 강도를 수집할 수 있으므로 이를 활용한 정밀 지도 작성도 가능합니다.

주변과 통신하다 - V2X(Vehicle-to-Everything) 기술

자율주행을 실현하는 기술 세 번째는 V2X(Vehicle-to-Everything)입니다. 자율주행차는 홀로 독립적으로 주행하는 듯 보이지만 사실 주변의 많은 도움이 필요합니다. 어린이들이 두발 자전거를 타기 전에 보조 바퀴를 달아 연습하는 것과 마찬가지이죠. 자율주행차의 안전하고 효율적인 주행을 위해서는 주변 정보의 활용이 필수적입니다. 운전자 입장에서도 보다 편한 운전이 가능합니다. 이를 위해 V2X 기술은 자율주행에서 빼놓을 수 없는 요소입니다.

이름에서 알 수 있듯 V2X는 자율주행차가 주변 기기 혹은 인프라와 데이터를 주고받는 통신 기술 일체를 뜻합니다. 그래서 V2X는 여러 하위 기술들을 나누는 개념이 다음과 같이 존재합니다.

V2X 하위 기술

- V2D(Device) : 주변 기기와 통신하는 블루투스나 와이파이 등의 기술

- V2I(Infrastructure) : 주변 인프라와의 통신으로 데이터 수집

- V2G(Grid) : 배터리 전력 활용 기술

- V2P(Pedestrian): 보행자와 통신하는 기술

(1) 차량과 주변기기의 통신, V2D (Vehicle-to-Device)

Vehicle-to-Device를 뜻합니다. 스마트폰 등 주변 기기와 자율주행차가 통신하는 블루투스나 와이파이 같은 기술이 포함됩니다. 구글의 안드로이드 오토, 애플의 카플레이와 같은 서비스가 존재하며 운전자는 V2D를 통해 자신의 기기를 차량에 연결시켜 다양한 정보를 주고받게 됩니다.

(2) 차량과 인프라의 통신, V2I (Vehicle-to-Infrastructure)

차량과 주변 인프라와의 통신을 뜻하는 Vehicle-to-Infrastructure입니다. 자율주행차는 기본적으로 시각 정보로 주변 환경을 파악하지만 V2I를 통하면 단순한 시각 정보가 아닌 데이터 값 자체를 주변 환경으로부터 받을 수 있습니다. 도로 표면 온도, 신호등의 값, 표지판의 안내 정보, 터널 내 기온 등 차량이 지나가는 구간에 구축된 시설로부터 유용한 데이터를 수집합니다. 따라서 V2I는 자율주행 제조사뿐 아니라 주행 시설을 설치, 운영하는 지자체나 기업과 긴밀한 협업이 중요합니다.

(3) 차량과 전력망의 통신, V2G (Vehicle-to-Grid)

자율주행차는 대부분 전기를 에너지로 사용합니다. 따라서 전원 공급 장치 혹은 전력망과의 양방향 커뮤니케이션이 중요한데 V2G 즉 Vehicle-to-Grid 기술은 자율주행차의 배터리 전력 활용과 직결됩니다. V2G는 세부적으로 위치에 따라 V2B(Vehicle-to-Building), V2H(Vehicle-to-Home) 등으로 나뉘며, 차량 배터리의 충전뿐 아니라 반대로 차량 배터리의 전력을 연결된 건물이나 전자 기기로 활용하도록 하는 기술도 포함합니다. 남는 유휴 전력, 비상시 전력 사용 등 다양한 상황에서 차량의 배터리 전력을 활용할 수 있게 되는 것입니다.

(4) 차량과 보행자의 통신, V2P (Vehicle-to-Pedestrian)

보행자(pedestrian)와 통신하는 Vehicle-to-Pedestrian도 빠질 수 없는 V2X의 요소입니다. V2P를 통해 자율주행차는 개별 보행자 1명 혹은 다수의 보행자와 소통할 수 있습니다. 차량이 움직임, 이상 상황 등을 보행자에게 전달하고 반대로 보행자는 자신의 디바이스를 통해 근처의 차량이 보내는 데이터를 수신하게 됩니다. 덕분에 주변 상황 파악을 오감에 의지할 수밖에 없는 보행자는 좀 더 면밀하고 선제적인 대응을 할 수 있게 됩니다. 자율주행차도 보행자의 안전을 지키는 한편 효율적인 주행을 하게 됩니다.

자율주행이 사람을 대체하는 날까지

지금까지 자율주행을 가능하게 해주는 3가지 핵심 기술을 살펴봤습니다. LiDAR, 카메라 등의 기기는 사람 운전자의 눈 역할을 대신하며, SLAM 알고리즘을 통해 자율주행차 스스로 자신의 위치를 파악하고 지도를 생성하게 됩니다. V2X 기술을 활용해 차량 스스로뿐 아니라 주행 환경과 정보를 통신하게 됩니다. 자율주행은 주행의 효율성뿐 아니라 안정성도 중요하므로 자율주행 자체의 하드웨어와 소프트웨어 그리고 주변 인프라 및 보행자와의 통신도 필수적인 고려 대상입니다.

아직 자율주행이 완벽하게 구현되지 않은 시점에서 이들 기술이 어떻게 발전되고 보완되는지 지켜보는 것은 상당히 중요하고도 흥미로운 포인트가 될 것입니다.

다음으로 인사이트 리포트 자율주행, 누구를 위한 기술일까요?를 읽어보세요!

![]()