다양한 비즈니스 영역에서 AI를 활용하여, 업무 프로세스를 혁신하여 초자동화를 이뤄내려는 시도가 늘고 있다. 초자동화는 그 기술 자체라기 보다는 ‘체계적인 문제 접근 방식’이다. 즉 AI와 머신러닝뿐만 아니라, 로봇 프로세스 자동화 (RPA: Robotic Process Automation), BPM / iBPMS (‘intelligent’ Business Process Management System), 통합 플랫폼 서비스 (iPaaS), low code / no code tools 및 다른 의사 결정도구나 조직의 베스트 프랙티스와 같은 기술, 도구, 플랫폼을 사용하여 최대한 많은 비즈니스 프로세스를 신속하게 찾아내고, 검증하여 자동화를 추진하는 체계적인 접근방법이라 할 수 있다.1 즉, 반복적이고 지루한 일련의 작업을 자동화된 시스템으로 대체하여, 인간이 더 가치 있는 업무에 집중할 수 있도록 하는 것이다.

그러나 이 부분은 큰 필요조건이 만족되어야만 가능하다. AI의 작업 과정을 인간이 충분히 이해하고 신뢰하지 못한다면, 기업에서의 AI 도입과 효과는 매우 불투명해질 수밖에 없다. 기업의 입장에서는 AI를 사용하여 업무효율을 10% 올리는 것보다, 과정에서 예상하지 못하고 이해하기 어려운 상황을 어떻게 처리할는지가 더 중요하기 때문이다.

예를 들어, AI에게 맡겨진 작업이 기업의 비용과 직간접적으로 연결이 되어 있어, 예상치 못한 금전 손실의 원인이 된다면, 아무리 많은 작업을 효율적으로 대신해주는 시스템이라 하더라도 신뢰하고 사용할 수는 없을 것이다. 또한 이것은 단순히 사용의 범위를 넘어, 전체 프로세스 중에 일어나는 중요한 결정에 대하여 AI의 예측 결과를 이해하고 수용할 수도 없게 된다. 즉 기업은 항상 혁신과 안정 중에 하나를 선택해야 한다면, 보수적이지만 안정적인 시스템을 선호할 수밖에 없는 조직이다.

AI 서비스가 실제 업무 프로세스에 통합되기 위해서는 먼저 투명성, 공정성, 안정성이 확보되어야 작업 위임이 가능해진다. 현재 AI 모델의 예측 한계를 명확히 표시하고, 신뢰도가 낮거나 중요한 의사결정을 포함하는 데이터에 대해서 인간이 직접 리뷰하고 수정하여 품질을 높이는 과정은 AI 서비스에 대한 신뢰도를 높이는 전략이 된다. 이런 과정을 휴먼인더루프(Human-in-the-loop; 이하 HITL)라고 부른다.

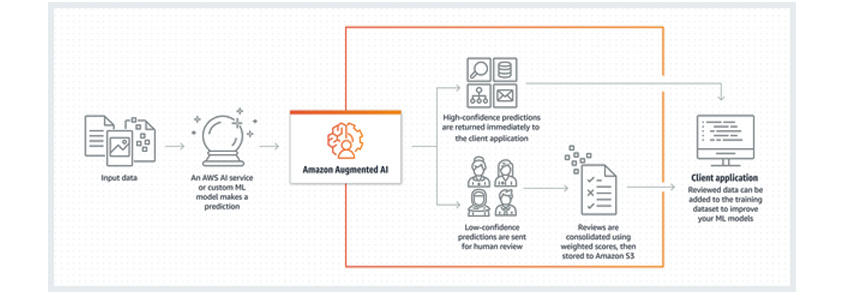

실례로 미국의 국가 보건 서비스(National Health Service, Business Services Authority)는 Amazon A2I (Amazon Augmented AI)를 사용한 HITL 프로세스를 통해 업무 혁신을 이루었다. 매달 5,400만 건에 달하는 종이 처방전과 문서로부터 필요한 텍스트, 정형 데이터를 추출하여, 일정 신뢰도 미만의 문서에 대해서는 사람이 직접 개입해 데이터를 리뷰 후 수정할 수 있도록 시스템화했다. 결과적으로 AI의 예측이 만드는 위험을 줄였고, 더 효율적으로 보험금 지급을 실행할 수 있게 되었다.2

- input data ->

- an AWS AI service of custom ML model makesa prediction ->

- high -confidence predictions are returned immediately to the client application->

- low-confidence predictions are sent for human review -> review are consdidated using srored to Amazon S3 ->

- client applications - reviewed data can be added to the training dataset to improve your ML models

이처럼 HITL은 사용자가 AI 서비스를 수용할 수 있는 이해도를 높이고, 작업 과정의 효율화를 이끌어낼 수 있기에 기업의 초자동화를 이끄는 핵심 프로세스가 될 수 있다. HITL에 대해서 좀 더 자세히 정의하고, 활용 방안을 알아보자.

신뢰할 수 있는 AI 업무 자동화

휴먼인더루프 즉, HITL 접근을 좀 더 명확하게 정의하면 “AI를 활용해 추출한 데이터가 실제 중요한 비즈니스 프로세스에서 사용되기 전에, 사람이 데이터를 직접 검증 및 수정할 수 있도록 하는 시스템을 추가하여 데이터의 품질을 보장하기 위한 접근 방식”이다. HITL을 AI 도입 과정에서 시스템화하기 위해서는 작업 과정에서 발생할 수 있는 오류 케이스를 인간의 작업이 어떻게 더 쉽게 수행할 것인지에 대한 고민이 필요하다.

아마존, 구글, 마이크로소프트와 같은 빅테크 플랫폼 기업의 경우엔, 자사의 AI 모델의 적용을 돕기 위한 관련 기능에 이미 HITL을 시스템화했다. 예를 들어, 구글은 Document AI에서 HITL과 관련된 다음의 4가지 기능을 제공하여, 검수 작업 관리에 대한 편의성을 높였다.

• 신뢰도 기준값 필터 설정

• 검수를 손쉽게 도와주는 기능과 사용자 인터페이스

• 검수 인력 관리 기능

• 검수 작업 및 검수자에 관한 분석 기능

먼저 사용자는 AI 작업 및 태스크 분류의 기준이 되는 신뢰도 점수를 직접 설정할 수 있다. 해당 신뢰도 점수를 기준으로 AI는 방대한 양의 문서에 대한 인식 작업을 진행한다. 이때 명확하게 인식하지 못한 문서에 대해서는 사용자가 주도적으로 수정할 수 있다.

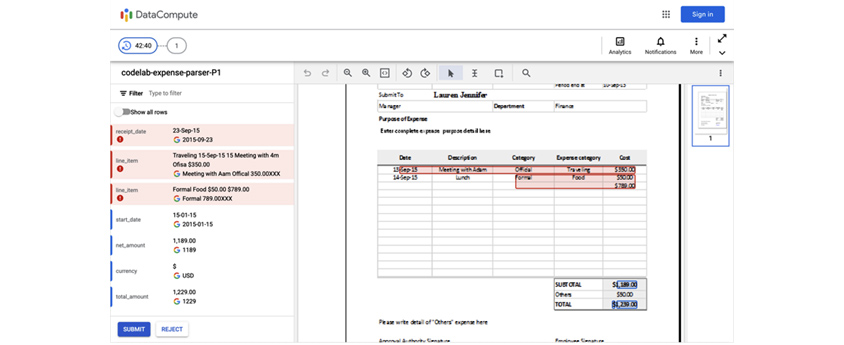

사용자의 인지 및 작업 흐름에 따라 맞춰 단순화한 사용자 인터페이스는 사람의 개입을 더욱 쉽게 만들어 데이터 품질 향상에 큰 도움이 된다. 적용 도메인 및 문서 특성에 따라 정확하게 인식하지 못한 예외 경우에는, 해당 문서를 분류한 뒤 선택적으로 확인하고 수정할 수 있게 시각적인 가이드를 제공한다. 예를 들어, 비용 지출 증빙 문서와 같은 정형화된 문서에서 날짜가 잘못 기입된 경우, 추출된 데이터에 빨간색으로 경고 표시를 한다. 또한 문서에서 인식된 영역을 표시하여 사용자가 맥락을 이해하고 수정할 수 있도록 지원한다.

[그림 2] 구글 Document AI의 HITL 예 (출처: 구글 코드랩스)

[그림 2] 구글 Document AI의 HITL 예 (출처: 구글 코드랩스)

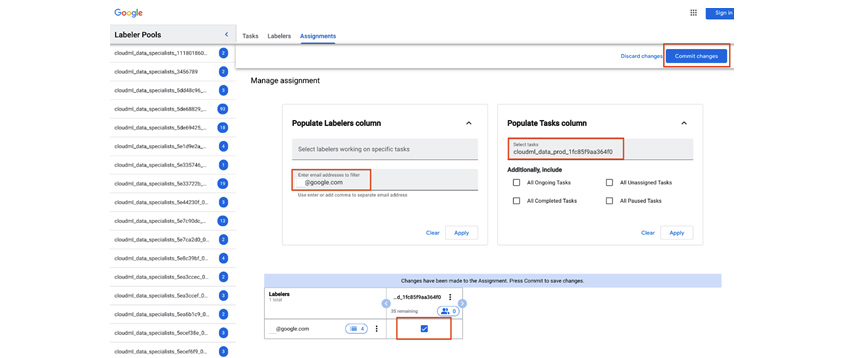

Document AI에서는 검수 작업을 사용자 스스로 진행할 수 있도록 하는 것뿐 아니라, 특정 검수 인력을 고용하거나, 내부 검수 인력을 관리한다는 점이 꽤나 인상적이다. AI 모델이 인식하지 못한 데이터에 대해서 인간이 검수 작업을 수행한다고 했을 때, 검수자의 변동, 태스크 할당을 동적으로 운영해야 하는 과정을 시스템적으로 해결하지 못한다면, 그 자체가 작업 오류 가능성을 높여 데이터의 품질 저하로 이어질 수 있다. 구글은 관리자의 대시보드에 검수 작업 할당과 인력, 비용 관리 기능을 제공하여, 관리자와 검수자의 커뮤니케이션 효율을 높였다. 또한 검수 작업과 검수 인력에 관한 분석 기능을 제공하여, AI와 인간 검수자의 작업 전환 과정과 효율을 동시에 높였다.

[그림 3] Document AI는 검수자에게 작업을 할당하고 관리하는 화면(출처: 구글 코드랩스)

[그림 3] Document AI는 검수자에게 작업을 할당하고 관리하는 화면(출처: 구글 코드랩스)

AI 모델의 발전을 위한 데이터 완결성과 재학습

HITL 프로세스는 AI 모델이 반복 학습 과정을 통해 데이터 품질을 높여 정교한 AI 서비스를 만드는 데에 기초가 되면서 동시에 사용자의 신뢰를 높일 수 있게 된다. 데이터 품질은 AI 모델을 위한 데이터 수집부터 그 서비스 운영까지 라이프 사이클 전체의 핵심이다. 특히, 일차 서비스 운영 환경에서 적용된 AI 모델의 성능을 유지하면서, 그 품질을 지속적으로 발전시키기 위해서는 HITL 시스템을 통해 강화된 피드백이 필요하고, 그것은 엄청난 효과를 발휘한다.

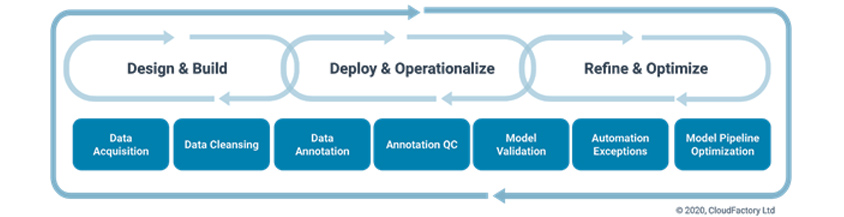

인간 검수자에 의해 수정 레이블이 된 데이터는 AI 모델의 학습 과정에 리얼타임으로 반영된다. 또한 범용적인 AI 모델이 특정 비즈니스 산업 모델에 특화된 모델로 진화하고, 자체적인 성능을 높이는 선순환 고리를 만들게 된다. 기존 모델이 인식하지 못했던 형태의 문서나 텍스트를 인간의 도움으로 인해 AI가 학습하게 되면, 그 이후의 작업은 스스로 가능하게 된다는 의미이다. 이전에는 이러한 데이터 정제 작업을 위해서 크라우드 소싱 등을 이용했지만, 그런 광범위한 작업은 모델의 유지, 보수에 시간과 비용 부담을 만들었다. AI 적용 단계에서 HITL을 시스템화한다면, 이러한 부담을 줄이고 기업의 목적 달성에 부합하는 AI 모델로 빠르게 진화시킬 수 있다. 클라우드 팩토리의 연구에 의하면, AI 모델의 강화 학습 과정을 위한 3가지 단계와 7가지 작업 과정을 다음의 그림과 같이 나누어 설명하고 있다.3

- Design & Build

- Deploy & Operationalize

- Refine & Optimize

- data acquisition / data cleansing

- data annotation / annotation QC /model validation

- automation exception / model pipeline optimization

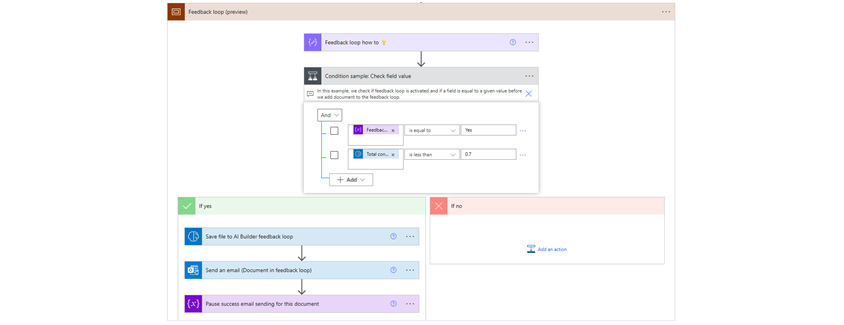

다른 빅테크 기업인 마이크로소프트의 경우를 예로 들어보자. 지난 11월 마이크로소프트는 AI Builder와 로우코드 툴인 Power Automate를 결합한 AI 작업 과정에 AI의 성능 개선을 위한 피드백 루프 기능을 발표했다.4 앞서 구글의 사례와 같이 사전에 학습된 AI 모델을 작업 프로세스 자동화에 적용시킨 후, AI 모델의 작업과 인간의 검수 작업이 포함된 자동화 흐름으로 구성하였다. 마이크로소프트는 여기에서 조금 더 나아가 특정 신뢰도 점수 등 사용자가 지정한 기준의 충족 여부에 따라 그 데이터가 AI 모델의 학습 데이터로 사용될지 여부를 결정할 수 있다.

[그림 5] 파워 오토메이트 내에서 AI Builder 피드백 루프를 사용한다 (출처: 마이크로소프트)

[그림 5] 파워 오토메이트 내에서 AI Builder 피드백 루프를 사용한다 (출처: 마이크로소프트)

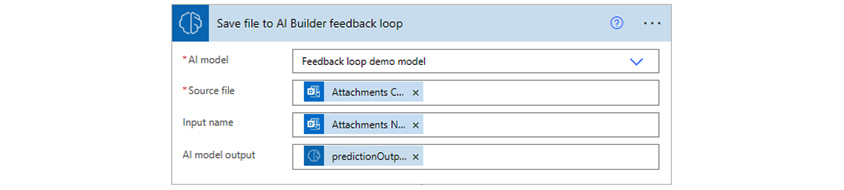

사용자가 지정한 기준을 충족하는 문서 또는 데이터의 경우, 인간의 개입 없이 사용 중인 AI 모델과 소스파일을 지정하고, 생성되는 출력용 AI 모델을 설정하여 즉시 피드백 루프로 연결시킬 수 있다.

[그림 6] 피드백 루프 설정 (출처: 마이크로소프트)

[그림 6] 피드백 루프 설정 (출처: 마이크로소프트)

조건을 충족시키지 못한 문서의 경우, 인간의 검수를 통해 문서가 수정될 수 있도록 한다. 이때 수정된 문서와 데이터를 다시 AI 모델의 학습 데이터에 추가하여 반복 학습하도록 지정한다. 이를 통해 사전 학습된(pre-trained)된 AI 모델은 해당 비즈니스 산업 환경에 더욱 최적화된다.

예를 들어, 기존의 학습된 구조 형식(영수증, 송장 등)이 아닌 새로운 문서의 형태가 해당 비즈니스에서 활용될 경우 초반에는 예외 케이스와 에러가 발생하게 되지만, 점차 해당 케이스를 포괄하는 모델로 발전한다. 이렇게 이미 배포된 AI 모델도 HITL을 활용한 피드백 루프를 통해서 해당 비즈니스 도메인에 더욱 적합한 모델로 진화하여 업무 효율성을 높일 수 있다. 텍스트 인식, 다중 언어 감지, 문서 처리 모델 등 다양한 모델의 비즈니스 적용에 있어서 HITL 프로세스를 시스템화한다면, 프로덕션 후에도 모델 유지 및 확장을 효율적으로 지원하는 동시에 성능을 유지할 수 있다.

확장적인 활용

완벽한 AI 모델이란 있을 수 없다. 여러 비즈니스에서 AI를 활용해 혁신을 이루고자 한다면, AI에 대한 기대뿐만 아니라 한계도 명확히 인지하고 관리, 발전시킬 수 있어야 한다. 또한 해당 비즈니스 산업 목적에 부합하는 특화된 AI 모델이 될 수 있도록 인간이 개입하여 지속적인 목적과 의도를 주입하는 과정이 필요하다. HITL 시스템은 프로덕션 환경에서 AI를 적용한 후에도, 반복적인 루프를 통해서 AI 모델의 한계를 보완하고 예외 케이스를 지속적으로 학습을 강화하는 방법이 될 수 있다.

HITL 프로세스는 B2B, B2C에 관련 없이, AI 모델을 직접 개발하고, 실제 애플리케이션이나 서비스에 적용하는 모든 비즈니스에서 적용할 수 있다. 그러나 HITL을 통한 성공적인 AI 서비스를 제공하고, 원하는 비즈니스 결과를 달성하는 것은, 인간의 개입과 피드백 과정을 얼마나 효율적으로 관리할 수 있는가에 달려 있다고 할 수 있다.

예를 들어, 자동 번역을 수행하는 일종의 번역 서비스가 오류가 있는 결과를 내보낼 경우, 해당 결과를 접한 사용자는 번역 결과를 올바르게 피드백해줄 자발적 의도와 역량을 보유했느냐는 매우 중요한 변수이다. 확장적인 언어 모델로 발전하기 위해서는 잘못된 결과를 라벨링하고, ‘누가’ 이를 올바르게 수정해줄 수 있는가를 결정하는 것 또한 매우 중요하다.

이런 점에서 사용자와 검수자는 다른 사람이 될 수 있다. 그리고 해당 피드백 루프에 속한 이해관계자의 역량과 동기에 따라 해당 수정 이후 데이터 품질이 개선될 수도, 혹은 더욱 악화될 수도 있다. HITL 프로세스의 확장적인 적용을 위해선 해당 AI 서비스를 ‘누가’ 사용할 것인지, 그리고 ‘누가’ ‘어떤 동기’로 해당 검수 작업에 참여할 것인지, ‘검수’에 참여하는 당사자는 절대적인 판단이 가능한 ‘역량’을 보유하고 있는지에 대해 확인하고, 작업 및 피드백 루프를 설계해 나가야 할 것이다.

Reference

1. 한국지능정보사회지능원, “초자동화 란 무엇이고 어떻게 얻어지는가?”, Dec, 2020

2. AWS, “Amazon Augmented AI Customers”

3. CloudFactory, “Human in the Loop: Accelerating the AI Lifecycle”

4. Microsoft, “Automate Document Processing end-to-end with AI Builder”, Oct 14, 2022

▶ 해당 콘텐츠는 저작권법에 의하여 보호받는 저작물로 기고자에게 저작권이 있습니다.

▶ 해당 콘텐츠는 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

SAP France의 Senior Program Manager

한국에서 컴퓨터 공학을 전공 후, 7년간 한국후지쯔에서 개발자로 근무하고, 1998년 프랑스 파리로 이주하여 Business Objects에서 개발 매니저와 프로그램 매니저를 거쳐, 현재 SAP의 클라우드 ERP 엔지니어링 그룹의 시니어 프로덕트/프로그램 매니저로 근무 중입니다. 책 <프로덕트 매니지먼트>의 저자입니다.