인류가 다른 포유류와는 달리 문명을 건설하고, 도구를 사용하면서, 과학이라는 성과를 내놓았던 데에는 지구상의 여러 개체들과 차별화되는 특징이 큰 역할을 했다고 봅니다. 첫 번째는 바로 '언어'예요. 즉, 텍스트(Text)로 소통하고 기록하면서 지식을 축적하는 것이죠. 두 번째는 다양한 시각 정보를 받아들이고 이해하는 '뇌의 처리능력'이에요. 마지막으로 세 번째는 후각과 미각, 통각을 비롯한 다양한 감각과 기억을 융합하면서 사물을 받아들이는 '지식 통합 능력'이에요.

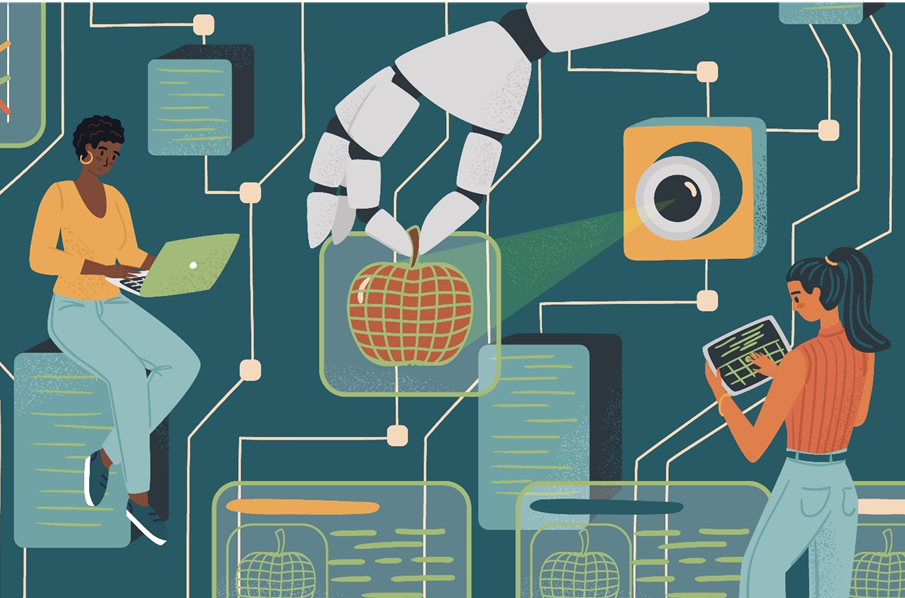

예를 들면 우리가 태어나서 처음 '사과'를 먹어 본 기억을 떠올려보세요. 사과라는 단어가 머리에 각인되기 전에 이미 사과를 맛보고, 그 생김새와 색깔, 크기, 그리고 시큼하면서도 달콤한 맛, 까끌 거리면서도 매끈한 촉감을 알게 됩니다. 그리고 비슷한 모양의 청사과 풋사과, 잘 익은 사과, 상하거나 멍든 사과까지 여러 종류의 사과를 알게 되고 나서는 그것을 묶어서 3~4살쯤 말을 배우게 되면, '사과(Apple)'라는 형이상학적 개념으로 뇌에 통합해서 저장하게 되죠. 이런 인류의 특별한 능력과 지적인 재능은 다양한 감각과 기억 등을 통합하는 역량에서 온 것입니다.

인류는 이렇게 사과라는 개념을 이해하기 위해서 시각과 미각, 촉각, 텍스트까지 여러 개념을 통합해서 인식을 했죠. 그렇다면 우리가 만드는 AI는 어떻게 사과라는 개념을 받아들일까요? 이왕이면 인간이 학습했던 방법으로 배워야, 인간과 제대로 소통할 줄 아는 AI가 되겠죠? 그래서 등장한 것이 '멀티 모달리티(Multi Modality)'입니다. 모달리티(Modality)는 '양식', '양상'이라는 뜻인데요. 보통 어떤 형태로 나타나는 현상이나 그것을 받아들이는 방식을 말합니다. AI가 등장하기 전인 10년전 쯤에는 웹 개발자와 UI 디자이너가 사용자에게 보이거나 입력하는 방식 등을 하나로 단순화하면 '유니 모달리티', 마우스와 키보드, 화면과 음성 등 여러 채널을 이용하면 '멀티 모달리티'라고 불렀던 시절이 있었습니다. 지금의 '멀티모달'은 시각, 청각을 비롯한 여러 인터페이스를 통해서 정보를 주고받는 것을 말하는 개념이며, 이렇게 다양한 채널의 모달리티를 동시에 받아들여서 학습하고 사고하는 AI를 '멀티모달 AI'라고 합니다. 쉽게 말하면 인간이 사물을 받아들이는 다양한 방식과 동일하게 학습하는 AI라고 볼 수 있겠네요.

멀티모달 AI는 기존 AI와는 어떻게 다를까요?

기존에 우리가 만들었던 AI는 텍스트나 자연어를 이해하는 데 중점을 두었습니다. 인류가 만든 가장 많은 데이터는 바로 글로 남겨진 텍스트였고, 사람이 주고받는 언어를 이해하는 자연어 분석(NLP)이 전제되어야, 명제와 추론을 할 수 있다고 본 거죠. 우선은 사람이 하는 질문을 이해해야 답을 내놓을 수 있기도 했고요. 그런데 여기서 문제가 발생하죠. AI는 실제 그 단어가 의미하는 것이 어떻게 생겼고, 실제 세상에는 어떤 형태로 존재하는지 이해하지 못하는 겁니다. 예를 들어 '남자가 말을 타고 있다'라는 문장에서 '탄다(ride)'라는 개념을 이해하지 못하고, 말의 크기가 얼마만 한 것인지, 어떤 형태로 타는 것인지 알 수가 없죠. 즉, 데이터 처리나 통계, 텍스트를 검색해서 보여주는 것은 가능하지만, 인간과 유사한 방식의 사고는 할 수가 없습니다. AI가 우리 세상을 제대로 인식할 수 있도록 하려면 멀티모달 AI의 등장은 필수적이었다고 봐야겠죠.

우리에게 가장 많이 알려진 OpenAI에서 만든 '달리(DALL-E 2)'는 'AI 시스템이 우리 인류를 어떻게 보고 이해하는지 도움 되도록 하고자' 멀티모달 AI를 활용해 만들었다고 밝혔습니다. DALL-E 2는 문장을 입력하면, 해당 문장이 어떤 형태의 그림과 사진으로 이해되는지를 보여줍니다. 즉, 우리가 입력한 문장을 DALL-E 2는 '이렇게 저는 이해하고 있어요'라고 보여주는데요. DALL-E 2는 기존 이미지들을 개체별로 나누고 이름을 부여한 다음, 위치와 색상, 어떤 동작을 하고 있는지를 이해합니다. 그리고 이미지를 설명하는데 이용된 텍스트 간의 관계를 학습하죠.

실제로는 이렇게 학습하지 않지만 쉽게 설명하면, 먼저 수많은 우주비행사와 고양이, 농구공 사진을 학습해서 '이렇게 생긴 거구나'를 형태로서 이해하고 나면, 어떤 사진에서든 그 개체를 분별해 낼 수 있습니다. 그리고 우주비행사는 우주유영을 어떻게 하고, 고양이는 어떻게 움직이고 앉아있는지, 농구공은 어떻게 사용되는지 동작(Move)을 이해하면 개체들이 어떻게 활용되는지를 알게 되죠. 그러고 나서 DALL-E 2에게 '우주에서 고양이와 농구를 하는 것'을 그림으로 만들어 달라고 하면 아래와 같은 그림을 만들어 줍니다. 한 가지 과정을 빠뜨렸네요. DALL-E 2는 인상파 화가 모네 스타일로, 앤디 워홀 스타일로, 어린이 동화 일러스트 스타일로 만들어 달라고 하면 그런 페인팅 기법도 이해하고 만들어 줍니다. 아래 이미지는 어린이 책의 삽화처럼 만들어 달라고 한 거라네요.

'우주에서 고양이와 농구를 하는 것'이라고 입력하면 이런 그림을 생성해 줍니다. (출처: OpenAI)

'우주에서 고양이와 농구를 하는 것'이라고 입력하면 이런 그림을 생성해 줍니다. (출처: OpenAI)

멀티모달 AI의 시대가 오면 어떻게 바뀔까요?

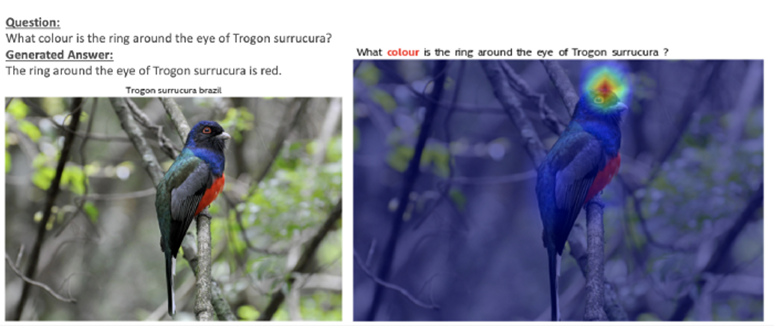

국내에서는 LG AI 연구원에서 텍스트를 이미지로 만들어주는 '엑사원'을 발표했는데요. 엑사원은 이미지를 텍스트로 설명해 주는 것도 가능한 양방향 멀티모달 AI라고 해요. 그리고 인텔과 카네기멜론대학이 손잡고 만든 'WebQA'는 웹상의 데이터와 이미지를 학습한 다음 사용자 질문에 답을 찾아주는 서비스입니다. 예를 들면 특정 새의 눈 주변 원 모양은 무슨 색상인지를 물어보면 빨간색이라고 답을 알려주죠.

아직까지는 이미지를 만들어 내고 검색하는 정도로만 활용되는 단계인데요. 텍스트와 이미지, 개체 관의 관계를 통해 AI가 학습하는 ‘확산(diffusion) 모델’을 사용해서 지식을 축적하는 단계라고 보면 될 것 같습니다.

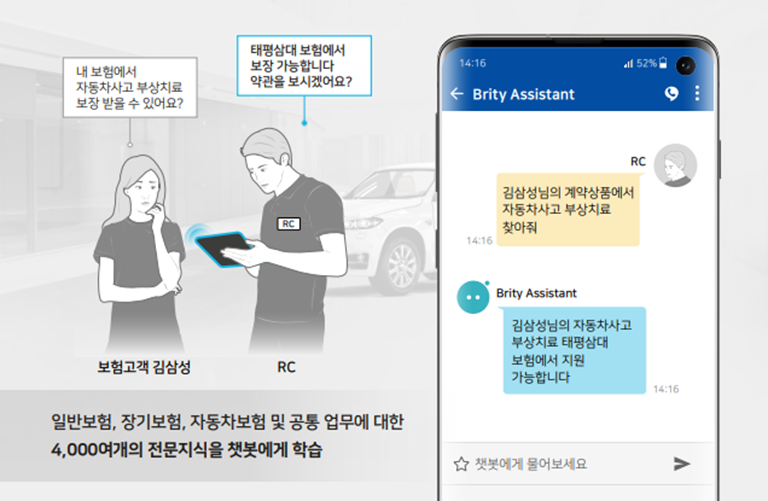

멀티모달 AI가 활성화되면 텍스트나 이미지로만 가능했던 활용 영역을 엄청나게 변화시킬 겁니다. 앞에서 예를 들었던 챗봇 AI는 단순하게 고객이 말하는 자연어를 분석해서, '이 정보를 찾아달라고 하는 거구나'를 목적으로 하는 게 대부분이죠. 멀티모달 AI라면 ‘번호판이 3X가1234인 차량의 전면부가 크게 파손되어 있는 사진’만 보험사에 전송하면, 해당 차량이 가입된 보험 상품을 검색하고, 고객의 피해 정도가 얼마나 될지 예측한 다음 담당자와 고객에게 사고 접수와 처리를 바로 진행하도록 해줄 수 있습니다. 즉, 정확한 상황 인지를 통해서 조금 더 명확한 판단을 내릴 수 있는 똑똑한 AI가 되는 거죠.

첩보영화에서나 보던 테러범의 이미지를 분석해서 CCTV에서 실시간으로 찾아내는 상상 속의 이야기가 실제가 될 겁니다. 자동차 업계에서는 자율주행에서 필수적인 속도, 차선 위반, 운전자의 상태, 날씨까지 여러 정보를 기반으로 하는 AI도 멀티모달 기반으로 구현되어야 될 테고요. 의료계에서도 사람의 눈으로는 알아낼 수 없는 질병의 초기 진단이나 원격 진료에서도 크게 활약할 것으로 예상하고 있어요. 사람과 동일한 방식으로 세상을 인지하지만, 더욱 날카롭고 정확하게 분석해 낼 수 있는 것이 멀티모달 AI가 될 테니까요.

그런 반면에 멀티모달 AI에 대해서 우려가 없는 건 아닙니다. 모든 AI의 가장 큰 위험요소는 '딥페이크'와 같은 AI 기반으로 만들어진 가짜가 범죄에 활용되거나, 편향되거나 폭력적인 이미지와 텍스트 등을 기반으로 학습되어서 나쁜 결과물을 만들어내는 것입니다. 그래서 DALL-E 2에서는 폭력과 혐오, 성인용 이미지는 학습 대상에서 제거하고, 공적인 인물을 포함해서 실제 개인의 얼굴을 보여주지 않습니다. DALL-E 2의 결과물을 보면 사람 얼굴이 조금 이상하게 표현되는 것은 그런 이유 때문이죠. AI의 미래는 사람과 동일한 책임이 따르도록 규제하는 것이 필요한 시대가 되었습니다. 여러분도 DALL-E 2에게 재미난 그림을 그려달라고 해보세요!

![]()