신뢰할 수 있는 AI 시스템1 논의 배경

사람이 해오던 전통적 의사결정과 행위를 AI 시스템이 대체하는 영역이 증가하면서 사람에게만 요구하던 윤리기준을 AI에도 적용할 수 있는지에 대해서 사회적 관심과 논란이 증가하고 있습니다. 전문가 시스템과 같이 추론 과정에 대한 이해가 상대적으로 용이하면서 전문가의 의사 결정과 행위를 보조하는 수단으로 활용되는 시대의 AI 시스템은 주로 기업 내부에 사용되면서 성능과 활용 범위 확대에 기업의 초점이 맞춰져 있었습니다.

* AI 시스템이란 : 머신러닝, 논리, 지식기반 접근법, 통계적 접근법 등을 활용해 개발되고, 인간이 정의한 목적을 위해 상호 작용하여 주변환경에 영향을 미치는 콘텐츠, 예측, 추천, 의사결정 등의 결과물을 생성할 수 있는 소프트웨어 (AI, H., 2019)

하지만 빠른 정보 전달이 가능한 5G 같은 무선 통신망의 발달, 수치 계산 속도가 비약적으로 증가한 GPU의 개선, 그리고 무엇보다도 딥러닝으로 통칭되는 비약적인 성능의 AI 학습 알고리즘의 발전은 사람을 대체하여 일반 소비자를 직접 상대하는 새로운 AI 시스템의 등장과 확산을 가속화했습니다.

반면, AI 시스템의 의사결정 과정은 복잡도가 증가하면서 일반인들에게 설명하기 어려운 소위 블랙박스 문제를 야기하였고, 이로 인해 AI 활동에 대한 불신도 덩달아 증가하였습니다. 공정성과 투명성을 강조하는 사회적 분위기의 변화도 AI가 피해 갈 수 없는 환경 변화입니다.

EU, 미국 같은 AI 기술 선진국은 한발 앞서 AI 시스템에 법적 책임을 요구하는 등 사회 어젠더로 등장하였고, 우리나라도 뒤이어 과학기술정보통신부, 방송통신위원회, 금융위원회 등에서 법안과 가이드라인을 예고하고 발표함으로써 본격적인 AI 윤리 규제의 시대로 들어가고 있습니다.

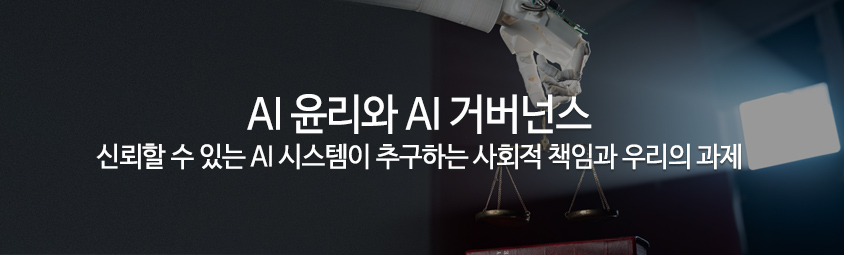

- 금융 AI 데이터 라이브러리 구축, 금융권 협업을 통한 데이터 공동 확보, 데이터 전문기관 추가지정

- 금융 AI 개발∙활용 안내서 발간, 설명가능한 AI 요건 마련, 망분리 및 클라우드 규제 개선

- 금융 AI 테스트베드 구축, AI 기반 신용평가모형 검증체계 마련, AI 보안성 검증체계 구축, AI를 활용한 효율적 감독체계 구축

AI 시스템과 ESG 경영

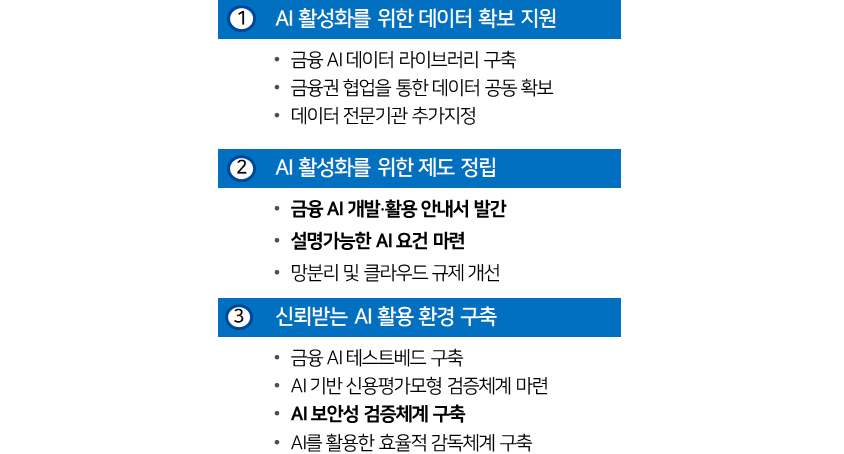

국내외 환경이 이렇게 흘러가면서 일반 소비자에게 AI 시스템을 기반으로 서비스를 제공하는 주요 대기업과 빅테크 기업은 AI 윤리 원칙을 수립하고 이에 기반하여 신뢰할 수 있는 AI 시스템을 개발 운영하기 위해 준비하고 있습니다. 이는 기업들이 추구하는 ESG 경영과도 밀접한 관계가 있습니다.

[그림 2]의 예시와 같이 ESG 경영에서 사회적 책임에 해당하는 Social은 개인의 프라이버시를 보호하고 개인이 속한 집단에 따른 부당한 차별을 금지하고 있는데 AI 시스템이 제공하는 서비스가 성별과 지역 등에 따라 차별하는 경우에는 이러한 원칙을 심각하게 위반하기 때문입니다.

- Environmental - 기후 변화 및 탄소 배출, 환경오염, 생물의 다양성, ...

- Social - 데이터 보호 및 프라이버시, 성별 및 다양성, 인권, ...

- Governance - 이사회 구성, 감사위원회 구조, 뇌물 및 반부패, ...

- Clearview.ai - 데이터 보호 및 프라이버시 : 얼굴인식 AI시스템 개발 기업으로, 학습을 위해 전세계 웹사이트와 SNS 회원 프로필에서 얼굴사진을 무단 수집

- Google - 성별 및 다양성 : 구글 포토의 AI태깅이 특정인을 잘못 태깅하여 인종차별 논란 발생

- amazon - 인권 : 배송기사의 안전 주행 점수 측정을 위해 차량 내부에 AI 카메라를 설치하여 녹화 모니터링

- -> AI서비스로 인한 사회적 문제가 지속적으로 발생하며 AI윤리의 중요성이 부각됨

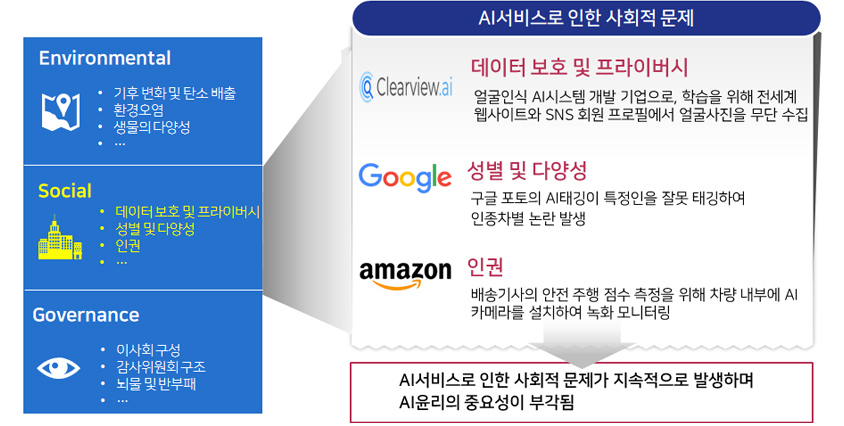

오늘날 대다수의 디지털 선두 기업들은 개별 고객의 성향에 맞춤화된 상품과 서비스를 추천하는데 챗봇에서 AI 음성 상담, 대출 심사에서 이상거래 탐지, 안면 인식에서 자율주행까지 그 범위가 날로 확대되고 심화하고 있습니다. 일부는 개인의 프라이버시뿐 아니라 생명에도 심각한 영향을 끼칠 수 있습니다. EU는 이러한 고위험 AI 시스템에 대해서는 별도의 규제를 정하고 있습니다. [그림3]

- Prohibited AI practices - / -> Unacceptable

- Regulated high risk Ai system - / -> High risk

- Transparency - / -> Limited risk

- No obligations - / -> Low and minimal risk

특히, EU의 AI Act4는 매우 강력한 규제를 수립하고 회원국의 동의절차를 진행하고 있습니다. 건강/안전/기본권에 악영향을 미칠 수 있는 고위험 AI 시스템을 제공하는 공급자, 수입업체, 유통업체가 규제를 준수하지 않는다면 시장에 제품을 출시하거나 수입, 유통을 금지한다는 것을 명시하고 있습니다.

만약 기업이 AI 시스템에 위험에 대해서 충분히 인지하고 이에 대비하지 못한 경우에 어떤 영향이 있을까요? 이에 대해서 몇 가지 사례를 중심으로 살펴보는 게 좋겠습니다. 국내에서 2020년도 12월에 발생했던 한 스타트업의 챗봇 윤리 문제 사례가 대표적 사례입니다.

해당 스타트업은 일반 고객을 대상으로 사적인 대화를 나눌 수 있는 챗봇 서비스를 공개하였는데 서비스를 제공하는 중에 주소와 같은 개인정보가 노출되었습니다. 또한 소수집단에 대한 혐오 발언이 사회적 논란을 빚으면서 서비스가 중단되고 개인정보 관리에 책임을 물어 과징금을 부과하고 피해자 소송이 진행되었습니다. 이 사건은 일종의 새로운 바이러스가 출현한 것처럼 사회적 관심을 받으며 법제도 정비를 촉진하면서 AI 서비스의 신뢰성에 대한 인식을 새롭게 하는 계기가 되었고, 해당 스타트업은 AI 윤리준칙과 윤리점검표, 프라이버시 보호정책 등을 정비하여 개선된 서비스를 제공하게 되었습니다.5

신뢰할 수 있는 AI와 관련된 개념

AI 시스템이 ‘신뢰할 수 있다’ 또는 ‘윤리적이다’라는 추상적인 개념을 구체적으로 정의하는 것은 쉽지 않습니다. 신뢰할 수 있는(Trustworthy) AI, 책임지는(Responsible) AI, 윤리적(Ethical) AI 등이 비슷한 빈도로 궁극적으로는 고객보호라는 유사한 목적을 위해서 사용되기도 합니다.

AI 시스템에 대한 규제와 학술적 연구가 활발하게 일어나면서 AI의 윤리에 대해서 정의하려는 노력이 많이 시도되었습니다. Jobin 등(2019)의 연구는 2016년부터 발표된 AI 윤리 원칙에 대해 논의된 84건의 문헌을 토대로 AI 윤리와 유사한 개념이 어떻게 사용되었는지 메타 연구를 통해 제시하였습니다. [표 1]

이 연구를 통해 우리는 AI 시스템의 투명성 또는 그와 유사한 개념에 대해 가장 많은 논의가 진행되었고 (84개 문헌 중 73개), 또 투명성이 어떠한 개념을 포함하고 있는지 확인할 수 있습니다. 투명성 다음으로는 정의 또는 공정성이 논의되었습니다. (84개 문헌 중 68개)

| Ethical principle | Number of documents | Included Codes |

|---|---|---|

| Transparency | 73/84 | Transparency, explainability, explicability, understandability, interpretability, communication, disclosure, showing |

| Justice & fairness | 68/84 | Justice, fairness, consistency, inclusion, equality, equity, (non-)bias, (non-)discrimination, diversity, plurality, accessibility, reversibility, remedy, redress, challenge, access and distribution |

| Non-maleficence | 60/84 | Non-maleficence, security, safety, harm, protection, precaution, prevention, integrity (bodily or mental), non-subversion |

| Responsibility | 60/84 | Responsibility, accountability, liability, acting with integrity |

| Privacy | 47/84 | Privacy, personal or private information |

| Beneficence | 41/84 | Benefits, beneficence, well-being, peace, social good, common good |

| Freedom & autonomy | 34/84 | Freedom, autonomy, consent, choice, self-determination, liberty, empowerment |

| Trust | 28/84 | Trust |

| Sustainability | 14/84 | Sustainability, environment(nature), energy, resources(energy) |

| Dignity | 13/84 | Dignity |

| Solidarity | 6/84 | Solidarity, social security, cohesion |

일반적으로 인격체에 부여되는 책임과 윤리에 비해 신뢰라는 개념은 신뢰성 기술과 도구를 대상으로 사용하며, 측정도구가 많이 개발되어서 AI 신뢰성에 대한 개념을 정의하고 수준을 측정하기가 상대적으로 용이합니다. 따라서, AI 신뢰성에 한정하여 논의하는 것이 보다 과학적 토론이 가능하겠지만, 이 글에서는 특별히 구분하지 않으면서 AI 시스템을 법인격화하고 규제와 연계시키는 부분에 대해서만 AI 윤리를 강조하려고 합니다.

글로벌 표준화 추진 및 기술 동향

일부 선진국에서 AI 시스템의 윤리와 관련된 법안 수립이 급속히 진행됨에 따라 기업이 AI 서비스와 관련된 리스크를 예방하는 방법을 표준화하기 위한 지표 수립, 모니터링 등 국제 표준과 기술/솔루션의 시장도 함께 성장하고 있습니다.

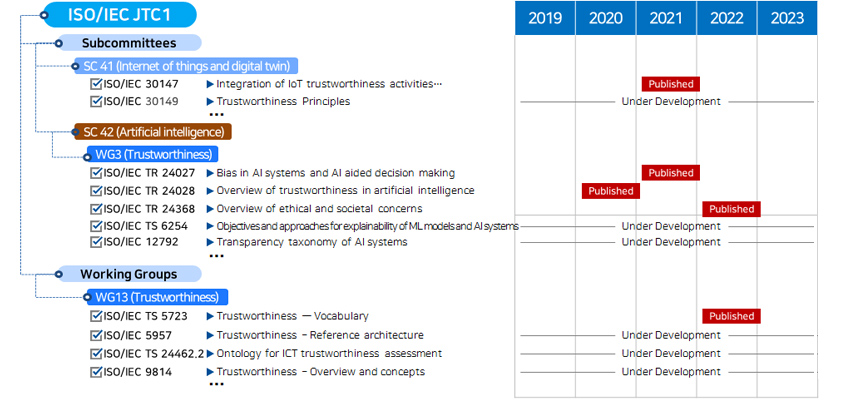

먼저 표준화의 동향을 살펴보면, ISO/IEC가 신뢰할 수 있는 AI에 대한 표준을 수립하고 있으며 이미 완료한 표준안을 발표하였습니다.[그림 4] 기업은 이를 활용하여 AI 시스템 개발과 운영에 필요한 실무 기준을 마련하면 외부 감독기관이나 향후에 마련될 수 있는 인증 체계를 준비하는 데 도움 받을 수 있습니다.

- Subcommittees

- SC 41 (Internet of things and digital twin)

- ISO/IEC 30147 -> Integration of IoT trustworthiness activities... / 2021 : published

- ISO/IEC 30149 -> Trustworthiness Principles / 2019 ~ 23 : Under Development

- SC 42 (Artificial intelligence)

- WG3 (Trustworthiness)

- ISO/IEC TR 24027 -> Bias in AI systems and AI aided decision making / 2021 : published

- ISO/IEC TR 24028 -> Overview of trustworthiness in artificial intelligence / 2020 : published

- ISO/IEC TR 24368 -> Overview of ethical and societal concerns / 2022 : published

- ISO/IEC TS 6254 -> Objectives and approaches for explainability of ML models and AI systems / 2019 ~ 23 : Under Development

- ISO/IEC 12792 -> Transparency taxonomy of AI systems / 2019 ~ 23 : Under Development

- Working Groups

- WG13 (Trustworthiness)

- ISO/IEC TS 5723 -> Trustworthiness — Vocabulary / 2022 : published

- ISO/IEC 5957 -> Trustworthiness – Reference architecture / 2019 ~ 23 : Under Development

- ISO/IEC TS 24462.2 -> Ontology for ICT trustworthiness assessment / 2019 ~ 23 : Under Development

- ISO/IEC 9814 -> Trustworthiness – Overview and concepts / 2019 ~ 23 : Under Development

AI 윤리와 관련된 기술은 크게 2가지 종류로 구분해 볼 수 있습니다.

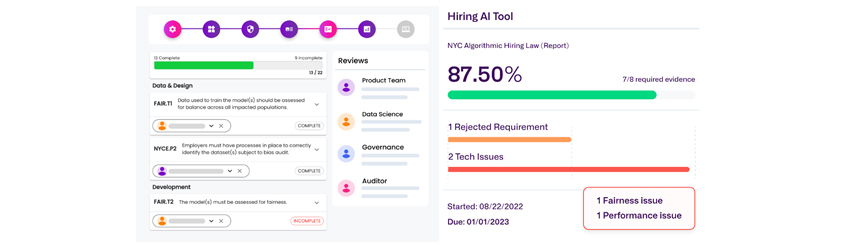

첫 번째는 측정형 기술입니다. AI 시스템의 공정성, 성능, 견고성, 개인정보보호 등을 잘 준수하고 있는지 확인하기 위해 데이터 수집, 학습, 평가 각 단계마다 AI윤리 준수여부를 정량적으로 평가할 수 있도록 도와주는 기술들이라고 볼 수 있겠습니다. 이 기술들은 MLOps와 결합하여 발생 가능한 리스크를 시스템으로 최소화하게 만드는 데 효과적으로 사용될 수 있으며 해외에선 이미 많은 기업들이 이러한 서비스를 제공하고 있습니다. 일례로 Credo AI라는 스타트업은 파이썬 기반의 소스코드를 Credo Lens라는 오픈소스로 공개하였고 이를 CI/CD 및 모니터링 앱과 연계한 AI Governance Platform을 서비스를 제공합니다. [그림 5]

[그림 5] Credo AI의 AI 윤리 모니터링 화면8

[그림 5] Credo AI의 AI 윤리 모니터링 화면8

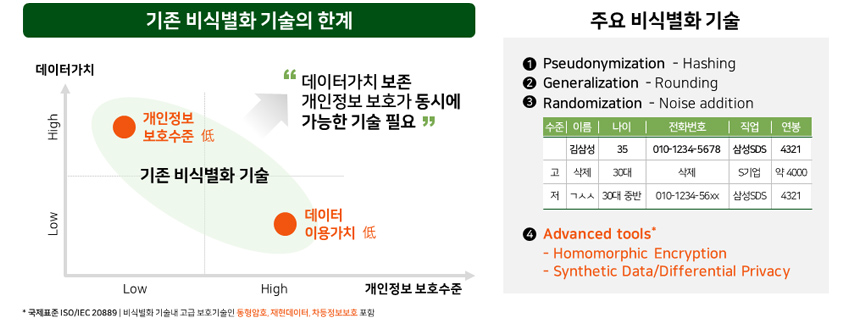

두 번째는 윤리적인 AI 서비스를 제공하는 데 도움을 줄 수 있는 활용형 기술입니다. 블랙박스처럼 이해하기 힘든 AI 시스템의 한계를 극복하고 학습의 투명성을 제고하는 데 도움을 줄 수 있는 XAI(Explainable AI), 개인정보를 보호하기 위해 학습 데이터 보안을 강화하는 동형암호화, 차분 프라이버시, 재현 데이터와 같은 기술이 여기 속한다고 볼 수 있습니다[그림 6]. 이 기술들은 학습 단계에 적용함으로써 윤리적인 AI 모델을 만드는 데 도움을 줄 수 있으며, 사용자의 문의나 이의 제기에 답변하도록 대응시스템을 구축하여 고객 권리를 보호하는 데 활용할 수 있습니다.

- 데이터가치 - high : 개인정보 보호수준 필수 / 데이터가치 보존, 개인정보 보호가 동시에 가능한 기술 필요

- 데이터 가치, 개인정보 보호수준 - mid : 기존 비식별화 기술

- 개인정보 보호수준 - high : 데이터 이용가치 필수 / 데이터가치 보존, 개인정보 보호가 동시에 가능한 기술 필요

- 국제표준 ISO/IEC 20889 | 비식별화 기술내 고급 보호기술인 동형암호, 재현데이터, 차등정보보호 포함

사회적 책임을 위한 AI 거버넌스

끝으로 과연 기업들이 ESG 경영을 하면서 신뢰받는 AI, 윤리적인 AI 서비스를 제공하기 위해서는 어떤 준비를 해야 하는지 논의해 보려고 합니다. 해외에서는 구글이나 메타와 같은 글로벌 메이저 플랫폼 기업들이 먼저 AI 윤리 원칙을 발표하고 내부통제 프레임워크를 통해 AI 시스템의 리스크를 관리할 수 있는 방안을 수립하고 있습니다. 국내에서도 선도기업과 금융회사는 AI 윤리 원칙을 발표하고 이에 의거하여 AI 서비스를 개발하고 소비자를 보호에 만전을 기하겠다고 선언하고 있습니다. [그림 7]

[그림 7] AI 윤리헌장 (삼성SDS)9

[그림 7] AI 윤리헌장 (삼성SDS)9

모든 것을 원점에서 준비할 필요는 없어 보입니다. 소비자를 대상으로 직접 서비스하는 다수의 대기업, 중소기업들과 마이데이터와 같이 광범위한 고객정보를 다루는 금융회사의 경우 내부통제 시스템이 이미 잘 갖추어져 있고 외부 감독기관으로부터 정기적인 검사를 받아왔습니다.

하지만, AI 시스템이 구성하고 있는 기술적 특수성을 고려할 때 별도의 AI 거버넌스가 필요한 시점입니다. 예를 들어 기존의 어플리케이션에 대한 품질, 보안 테스트는 코드 인스펙션을 기반으로 수행이 되고 있으나, AI의 추론은 블랙박스 영역인 모델 내부에서 이루어지기 때문에 기존 방식으론 충분히 검증했다고 볼 수 없을 것입니다.

따라서, AI 윤리 원칙 수립 이후에는 각 기업들이 현재 제공하고 있는 AI 기술이 포함된 제품, 상품, 서비스가 위에서 논의한 공정성, 성능, 견고성, 개인정보(Differential Privacy)를 준수하는지, 기술적 특수성에 의해 간과되는 부분은 없는지, 기업이 정한 AI 윤리 원칙에 비추어 추가로 정해야 할 지표와 모니터링이 필요하지 않은지 면밀한 진단이 필요할 것입니다.

다만 지나치게 강한 내부 규정으로 인해 AI 기술을 활용해서 기업이 혁신적인 서비스를 개발하는데 지장을 받지 않아야 할 것입니다. EU에서 AI Act를 수립 시 검토했던 내용이나, 국내의 관련 부처에서 강한 법률적 통제보다 가이드라인을 배포함으로써 업계에서 스스로 원칙과 기준을 만드는 자율규제를 권장하는 방향도 이런 연유에서 비롯되었다고 말할 수 있겠습니다.

검증된 기술을 기반으로 개별기업이 보유한 지적 자산이 유출되지 않고 기업의 사업 특성에 부합하며 경쟁력이 침해되지 않는 선에서 AI 거버넌스가 수립되어야 할 것입니다. 앞에서 소개 드린 기술과 글로벌 표준들은 기업의 이러한 고민을 해결하면서 소비자를 보호하고 AI 윤리 경영을 준비하는데 좋은 출발점이 될 것입니다.

References

1. AI, H. (2019). High-level expert group on artificial intelligence. Ethics guidelines for trustworthy AI, 6.

2. 『금융분야 인공지능 활용 활성화 및 신뢰확보 방안』, 금융위원회 보도자료 2022. 8.4

3. Artificial intelligence act (europa.eu)

4. Kop, M. (2021, September). EU Artificial Intelligence Act: The European Approach to AI. Stanford-Vienna Transatlantic Technology Law Forum, Transatlantic Antitrust and IPR Developments, Stanford University, Issue.

5. 스캐터랩, AI 챗봇 윤리점검표 발표 - ZDNet korea

6. Jobin, A., Ienca, M., & Vayena, E. (2019). The global landscape of AI ethics guidelines. Nature Machine Intelligence, 1(9), 389-399.

7. SC 42 - JTC 1 (jtc1info.org)

8. https://www.credo.ai/solutions

9. https://www.samsungsds.com/kr/digital_responsibility/ai_ethics.html

▶ 해당 콘텐츠는 저작권법에 의하여 보호받는 저작물로 기고자에게 저작권이 있습니다.

▶ 해당 콘텐츠는 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

조남용

삼성SDS 컨설팅팀

기업 고객 대상으로 AI, Data 기반 Digital Transformation 컨설팅을 담당하고 있습니다. 신뢰할 수 있는 AI가 AI 서비스 기획의 가장 기본이 될 것이며, 기업들이 외부 협업을 통해 AI 거버넌스를 수립하고 지속적 통제가 가능한 AI 플랫폼을 도입하는 것이 필요하다고 봅니다.

이상현

삼성SDS 컨설팅팀

최근 몇 년간 AI 기반의 OCR, 챗봇, 가상인간 개발 등 가장 각광받던 금융회사 AI 프로젝트에 참여한 행운을 누렸습니다. 윤리적 AI 알고리즘과 설명가능성에 관심을 두고 있으며, SDS 클라우드에 AI 기술허브를 구축하여 기업 고객과 소통하기를 꿈꾸고 있습니다.