2012년 국제영상인식대회(ImageNet Large Scale Visual Recognition Challenge)에서 심층학습(Deep Learning)은 전통적인 AI 대비 압도적인 성능을 학계 및 산업계에 선보이면서 3번째 AI 황금기의 신호탄을 올리게 됩니다. 그리고 2017년 이미지 인식 정확도는 98% 이상을 넘어서면서 인간의 인지 능력을 넘어서는 것이 가능함을 보여 주었습니다. 또한 심층강화학습(Deep Reinforcement Learning)으로 구현된 알파고(AlphaGo)는 절대로 정복할 수 없을 것 같았던 최강의 바둑기사를 연달아 이겼으며, 2020년 알파폴드(AlphaFold)는 단백질구조예측대회에서 2등(40점)과 압도적인 격차로 1등(60점)을 차지하면서 3번째 황금기를 이끌고 있습니다. 최근 GPT-3(Generative Pre-trained Transformer 3)이 만든 문장은 인간이 작성한 문장과 구별이 거의 불가능하며 글짓기, 번역, 언어 관련 문제풀이, 지시사항에 따른 코딩까지 인간에 근접한 엄청난 영향력과 잠재력을 보이고 있기 때문에 3번째 황금기는 기존보다 오래갈 것으로 예상됩니다.

기존 신경망의 한계를 해결한 Model-Centric AI의 대표주자인 심층학습은 우리에게 무한한 지평을 암시하는 듯 했고 많은 전문가들이 이제 인간 수준의 AGI(Artificial General Intelligence)가 멀지 않았다고 말하기도 했었습니다. 하지만 2018년도부터 Gartner(정보기술 연구 및 자문 회사)와 VentureBeat(IT 전문 매체)의 리포트에 의하면, 80~87% 이상의 AI•빅데이터 프로젝트가 실패로 끝나고 있다고 발표했으며 Gartner의 애널리스트 Svetlana Sicular는 ‘2020년은 AI의 하강이 시작하는 해’라는 진단을 내놨고, MMC Ventures(벤처캐피탈 펀드)는 유럽의 AI 스타트업을 조사한 뒤 이 중 40%가 아예 AI 기술을 쓰지 않는다고 발표했습니다. AI에 대한 우리들의 기대치와 실제 현실 간 격차는 생각보다 크다는 것입니다. 1960년대 Marvin Minsky가 5~8년 내에 인간 수준의 AI가 나올 것이라고 말했던 그 당시와 60년이 지난 지금, 우리는 얼마나 Super AI에 가까워졌고 언제 가능하다고 말할 수 있을까요?

AI의 3대 거장들은 이런 기대에 대해서 우려의 시선을 보내고 있습니다. Yoshua Bengio는 지금의 딥러닝은 시스템1인지 기술(단순 지각, 예: “개”와 “고양이” 구분)에 국한된 것이며, 인간의 의식 흐름(Conscious Process)과 같은 것을 표현하는 시스템2 인지 기술과는 거리가 멀다고 말하며, AI에 거는 과도한 기대에 대해 우려를 표했습니다. Geoffrey Hinton은 시스템1인지 영역에서 최고의 성능을 보이는 딥러닝 모델조차도 정제된 데이터들을 상당히 많이 요구한다는 한계를 지적했습니다. Yann LeCun역시 레이블(Label)이 많이 필요한 지도학습(Supervised Learning)의 한계를 지적하고 지속적인 단순 관측에 의해 스스로 학습하는 자가지도학습(Self-Supervised Learning)을 차세대 AI로 말하고 있습니다. 이 외에도 비전 인식 분야 중국 최고 수장인 Jue Wang교수와 Zhi-Hua Zhou 교수 역시 데이터의 분포가 시간에 따라 변하는 문제를 말하면서 현재 AI 학습 이론의 한계를 지적하였으며, 뉴욕대학교 인지심리학 교수 Gary Marcus는 Google DeepMind가 18년도 5.7억$ 비용을 들여 1.2만 명이 3일 연속으로 학습한 성과가 얼마나 실리적인가를 꼬집으며 다소 냉소적인 관점에서 딥러닝의 한계에 대해 발표하였습니다. AI의 대가들이 말하듯이 이제는 딥러닝의 잠재력을 전파하기보다는 한계를 인지하고 다시 도약할 미래의 방향을 찾아야 할 때입니다.

연쇄적 기하 변환을 하는 계층적 표현 학습에 불과하다 "

- Keras 창시자 François Chollet -

대규모 AI의 모체인 딥러닝이 나타난 지 10년이 지난 지금도 왜 수많은 응용 상용화로 직결되지 않는 이유가 무엇인지 생각해야 합니다. 최근 인기를 끌고 있는 GPT-3의 문장 생성 기능은 딥러닝의 무한한 가능성을 보여주는 또 하나의 사례입니다. 강력한 컴퓨팅 파워를 기반으로 엄청난 양의 데이터를 정제하고 1,750억 개의 매개변수를 조절함으로써 높은 성능을 자랑했습니다. 하지만 이 역시 주어진 단어에 대해 통계적으로 가장 잘 어울리는 다음 단어를 추론하는, 대규모 언어 모델 기반의 시스템1인지 기술입니다. 이 엄청난 AI 기술도 “냉장고에 아이스크림을 넣으면 녹을까?”라는 일상적인 질문에는 “그렇다”라고 대답하는 물리적 상식을 가지지는 못합니다. 케라스의 창시자도 말했지만, 현재 우리가 사용하고 있는 딥러닝 1.0은 수많은 레이블을 기반으로 입력 공간을 레이블 표적 공간에 사상하기 위한 연쇄적 기하 변환일 뿐입니다.

우리가 많이 회자하는 대규모 AI의 사례인 왓슨, 알파제로, 알파고, GPT-3과 같은 AI 시스템들은 복잡한 정보량을 가진 정제된 레이블 데이터셋이 빅데이터 수준으로 제공되거나, 수백만 번의 시행착오(폭발, 사고, 충돌, 게임 행동 등)나 시뮬레이션을 통한 데이터를 학습하기 때문에 성공적일 수 있었습니다. 하지만 실세계(자연 현상)에서 이 같은 환경과 조건이 주어지는 상황이 얼마나 있을까요? 관측한 데이터가 실세계의 지배 현상을 전부 설명할 수 있을 만큼의 충분한 정보량을 가진 품질을 보장 할 수 있을까요?

앞서 언급한 전문가들이 AI 한계의 요인에 대해 공통으로 언급하는 것이 있습니다. 현실 그리고 자연의 방대한 역사적 데이터셋을 스스로 그리고 손쉽게 제공받을 수 없으며, 실제 세계의 규칙성을 파악하기 위해서는 “적은 양의 조잡한 데이터"로 광범위한 신경망을 학습시키기 위한 견고한 새로운 기계학습 이론을 만들어야 한다는 것입니다. 응용 상용화가 실패하는 것은 “강력한 계산 이론” 기반의 기계학습법, 즉 표현 수용력이 높은 심층신경망 기술을 모르기 때문이 아닙니다. 실세계에서는 기계에게 학습시키기에는 너무나 적고 조잡한 낮은 품질의 데이터만 얻을 수 있기 때문입니다.

강건한 학습 이론이 필요하다 "

2021년 3월 Andrew Ng은 위 문제를 직접적으로 해결하기 위한 방향을 제안했습니다. 한 예로 Steel 제조업에서 개발한 불량품 탐지 AI 시스템을 테스트한 결과 76.2% 정확도를 보였으며, 딥러닝 알고리즘의 Hyper-parameter를 튜닝하는 Model-Centric AI 접근법으로는 성능을 90% 이상으로 개선할 수 없었습니다. 하지만 Data-Centric(훈련/검증 데이터셋 분할, 오염 레이블 제거 등) AI 접근법으로 정확도를 93.1%로 개선할 수 있었습니다. Andrew Ng은 Data-Centric AI의 중요성을 설명하면서 Model-Centric AI의 한계를 설명하였습니다. 대규모 AI의 연구도 중요하지만, 성공적인 AI를 위해서는 기본적으로 첫째, 오염된 데이터셋을 보정하여 Clean Labels로 만드는 기술과 둘째, 품질이 좋은 새로운 데이터를 새로 자동 생성하는 기술을 연구해야 한다는 것입니다.

Andrew Ng의 사례도 보이지만 Data-Centric AI를 이용한 성능 개선 사례는 실제 제조 업계 AI에서 자주 발견됩니다. 공장 설비에서 주어진 원데이터(Raw Data)로 불량품 분류 모델을 학습했을 때는 53%의 정확도를 보였으나, 데이터 분석을 통하여 잘못된 레이블 4개를 보정 및 제거하여 재학습한 경우 71% 정확도로 크게 성능을 개선할 수 있었습니다. 또 다른 사례로, 복잡한 웨이퍼 패턴(Wafer Pattern, 미세회로 패턴이 새겨진 기판으로 반도체 집적회로의 핵심 재료)을 군집화(Clustering)하고자 했을 때, 패턴이 고차원으로 매우 복잡하여 전통적인 기법으로는 56% 정확도로 현장에 적용할 수가 없었습니다. 이 또한 데이터 분석을 통하여 데이터 품질과 모델 정확도에 악영향을 주는 원인이 노이즈성 미세 Pixel들과 카메라 축의 흔들림이라는 것을 파악하였고, 피처 전이 학습(Feature Transfer Learning)을 이용하여 자동으로 노이즈를 보정한 후 군집화한 결과 정확도가 78%로 개선되는 것을 확인하였습니다.

수많은 데이터 사이언티스트들이 참여한 모델 생성 사례를 보면 더욱 극명하게 왜 Data-Centric AI가 중요한지 알 수 있습니다. 가전제품은 수만 개 이상의 제품을 출하하기 전에 내부의 불량 및 품질 검사를 해야 합니다. 문제는 내부결함을 검사해야 하기 때문에 마이크로웨이브로 측정된 데이터를 사용해야 한다는 것과 정상 데이터는 수천 개가 넘지만, 불량은 단지 몇 십 개뿐이라는 것입니다. 이 데이터 분석 문제를 경진대회에서 사내 100여 명의 분석가들이 답안을 제출하였습니다.

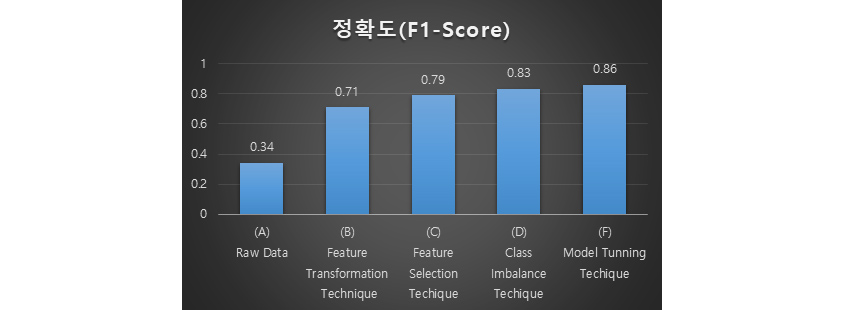

- A:Raw Data -0.34

- B:Feature Transfomation Technique -0.71

- C:Feature Selection Technique -0.79

- D:Class Imbalance Technique -0.83

- F:Model Tunning Technique -0.86

*F1-Score : 조화평균으로 주로 분류 클래스 간 데이터가 심각한 불균형을 이루는 경우에 사용하는 평가지표

답안을 제출한 분석가 중 원시데이터 그대로 학습 모델에 이용한 95% 이상의 분석가들의 모델 성능은 (딥러닝을 이용하기도 하였지만) 정확도(F1-Score)가 34%(Fig. 1 A)도 넘지 못하였습니다. 70%(Fig. 1 B) 이상의 의미 있는 모델을 생성한 분석가들은 기법은 각각 다르지만 모두 “시계열 음향데이터 특성을 파악”하여 신호분해기법(FFT, MFCC등)을 이용하여 주파수 도메인으로 피처를 변환하여 학습하기 좋은 데이터를 생성하였습니다. 그리고 변환한 피처 중에서도 레이블과 관련성이 높은 변수만 선택하여 학습한 경우79%(Fig. 1 C)를 보였으며 클래스 불균형 문제까지 동시에 해결한 분석 모델은 83%(Fig. 1 D)의 성능을 보였습니다. 이런 지능적 전처리를 수행한 이후 하이퍼파라메터 최적화나 좀 더 학습 수용력이 높은 모델을 변경할 경우 86%(Fig. 1 F)로 추가적인 성능 개선이 이루어졌습니다. 이러한 데이터에 대한 이해와 학습 이론에 대한 접근 없이 아닌 원시데이터를 그대로 이용하거나 하이퍼파라메터 튜닝, 합성곱 심층신경망을 이용한 접근법으로는 유의할만한 모델이 생성되지 않았습니다. 즉, 학습데이터의 품질이 좋아야 모델 튜닝의 효과도 크다는 것입니다.

이런 데이터 품질의 중요성은 제조에 국한된 것이 아닙니다. 8월 테슬라 AI 데이에서 자율주행 AI를 위해 적용한 기술 가운데 새로운 하드웨어 칩을 설명하기도 했지만, 1,000명의 라벨링(Labeling) 인력, 자동 라벨링(Auto-Labeling) 툴 비중의 확대, 그리고 희귀한 상황까지도 가상 시뮬레이션으로 분석하여 고품질의 데이터를 확보한 것들이 핵심 기술임을 강조하였습니다.

Data-Centric AI 기반의 소수 1% 연구만이 성과를 내왔다 "

정리하자면 AI 성능의 80%는 데이터 품질에 의해서 결정된다는 것입니다. 그렇지만 Andrew Ng이 지적하듯이 현재까지 99%의 AI 연구는 Model-Centric 접근법이며 1%만이 Data-Centric 연구를 진행 중이라는 것입니다. 물론 대량의 고품질 데이터 수집이 가능한 영역에 있어서는 기존 심층학습 기법이 여전히 주요 해결책이 될 것입니다. 하지만 현재까지의 Model-Centric AI는 연구실이나 실험실의 관점의 접근법이며 수리적 학습이론을 만족하는 데이터셋 들이기 때문에 고성능의 수용성 높은 표현학습 기술을 확보하는 것에 초점이 맞추어져 있으며 이것만으로는 응용 상용화 수준에 도달할 수가 없다는 것을 이제는 인지해야 한다는 것입니다.

다른 분야와 다르게 AI 기술은 학계가 아닌 산업체에서 주도하고 있는 이유는 수리통계적 학습이론을 깊게 숙지해야 하는 것 외에, 각 물리 현상 별 데이터 생성 과정(Data-Generation Process)을 동시에 이해하여 “학습이 실패하는 원인을 빠르게 이해하고 이를 해결하는 알고리즘을 빠르게” 만들어내야 하기 때문입니다. 즉, 소량이면서 조잡하며 변화하는 데이터들로 어떻게든 현실의 복잡한 지배 현상을 학습해 내는 Data-Centric AI 기술로 이동해야 합니다. 그래야만 AI 응용 상용화의 성공율은 높아질 것이며, AI가 특정 소수 인력의 소유물로 남아 있는 우리가 직면한 현실적인 문제를 해결할 수 있습니다.

▶ 해당 콘텐츠는 저작권법에 의하여 보호받는 저작물로 기고자에게 저작권이 있습니다.

▶ 해당 콘텐츠는 사전 동의 없이 2차 가공 및 영리적인 이용을 금하고 있습니다.

![]()

삼성SDS AI Analytics팀

대학원에서 기계공학 & 컴퓨터사이언스를 전공하였고 주요 연구분야는 Applied mathematics(응용수학) 기반 Manufacturing 데이터분석 및 최적화입니다. 현재 전자 및 관계사 데이터기반 무인설계기술과 공정최적제어 관련 컨설팅을 수행 중이며, 삼성SDS Brightics AI 알고리즘 중 Optimization 기술리더입니다. 관심분야는 능동학습(Active Learning)과 전이학습(Transfer Learning) 이용한 전통적인 AI기술 (강화학습을 비롯한 머신러닝)의 비효율성 해결과 자율학습 기술 연구 중입니다.