Sách trắng phân tích công nghệ ChatGPT - Phần 2: Sử dụng ChatGPT

ChatGPT Web UI

OpenAI khởi đầu là một tổ chức phi lợi nhuận, nhưng đã thay đổi cơ cấu vào năm 2019 để thu hút đầu tư và nhân tài, hiện bao gồm OpenAI Inc - một tổ chức phi lợi nhuận và OpenAI LP (Limited Partners) - một tổ chức có giới hạn lợi nhuận (Capped-profit).OpenAI LP giới hạn lợi nhuận cho mỗi nhà đầu tư và phần lợi nhuận vượt quá sẽ được chuyển về tổ chức phi lợi nhuận OpenAI Inc.Về mặt cấu trúc, OpenAI không phải chỉ theo đuổi lợi nhuận, nhưng liên quan đến mô hình ngôn ngữ thì nó có mô hình kinh doanh trong đó doanh thu được tạo ra thông qua hình thức thành viên trả phí Web UI ChatGPT hoặc đăng ký trả phí API (Application Programming Interface).ChatGPT có thể được sử dụng bằng hình thức đối thoại thông qua Web UI (https://chat.openai.com/).Bạn có thể nhận được phản hồi bằng cách nhập và gửi tin nhắn qua cửa sổ chat.Tính đến thời điểm hiện tại (tháng 3 năm 2023), phiên bản GPT-3.5 được cung cấp miễn phí, nhưng khi đăng ký thành viên ChatGPT Plus ($20 mỗi tháng), người dùng có thể sử dụng phiên bản GPT-3.5 nhanh hơn và chất lượng cao hơn, kèm theo phiên bản GPT-4 mới ra gần đây nhất.Nói cách khác, khi sử dụng ChatGPT thông qua Web UI, người dùng có thể chọn tính năng của các câu trả lời sẽ nhận được và đạt được các cuộc hội thoại chất lượng cao theo thứ tự sau: GPT-3.5 (miễn phí) GPT-3.5 (trả phí) và GPT-4 (trả phí).

ChatGPT API

API là một công cụ giúp hai ứng dụng khác nhau có thể giao tiếp với nhau. Thông qua API, lập trình viên chỉ có thể truy cập và sử dụng các tính năng, dữ liệu của chương trình do đối phương tạo ra mà không cần biết thông tin triển khai chi tiết. Nhờ đó có thể tiết kiệm thời gian và tạo ra sản phẩm mới bằng cách mượn và tận dụng tính năng của các giải pháp hiện có do đối phương phát triển. Các mô hình ngôn ngữ mà OpenAI cung cấp API là GPT-3, GPT-3.5, Codex (chuyển đổi từ ngôn ngữ tự nhiên sang SQL, từ Python sang ngôn ngữ tự nhiên, giữa các ngôn ngữ lập trình với nhau v.v.). API cho mô hình GPT-4 hiện chỉ được cung cấp cho một số người dùng, nhưng bạn có thể đăng ký vào danh sách chờ. Nếu đăng ký OpenAI và nhận API Key định danh cá nhân, người dùng có thể thử gọi máy chủ OpenAI bằng cách nhập giá trị API Key vào cửa sổ lập trình (Python, v.v.), nếu được cho phép truy cập, văn bản đầu vào sẽ được gửi đến máy chủ OpenAI và câu trả lời được xử lý bởi mô hình GPT-3.5↑ được lưu trữ trong máy chủ OpenAI sẽ được xuất ra thông qua cửa sổ lập trình.Mô hình GPT-3↑ tồn tại trên máy chủ của OpenAI và chỉ được phép truy cập để sử dụng tính năng, vì vậy có thể gửi dữ liệu của người dùng đến máy chủ đó và chỉ có thể nhận được câu trả lời cuối cùng đã được xử lý và xuất ra bởi mô hình trong máy chủ (phát sinh chi phí).

Ngoài ra, để tinh chỉnh mô hình GPT-3↑, dữ liệu của người dùng phải được gửi đến máy chủ của OpenAI (phát sinh chi phí) và mặc dù đây là mô hình đã được tinh chỉnh với dữ liệu của người dùng nhưng mô hình này cũng được lưu trữ trên máy chủ và để sử dụng mô hình được tinh chỉnh, dữ liệu của người dùng cần được gửi lại đến máy chủ và chỉ nhận câu trả lời xuất ra cuối cùng (phát sinh chi phí). Phí sử dụng API của OpenAI được tính dựa trên phiên bản mô hình, tính năng chi tiết, mức sử dụng. Mức sử dụng được đo bằng số lượng token (Token là đơn vị nhỏ nhất của các câu và từ được chia nhỏ để xử lý ngôn ngữ tự nhiên) và trong tiếng Anh, 1 token thường được tính là 4 chữ cái (=0,75 từ).

| Mô hình | Mô hình Cơ bản | Mô hình Tinh chỉnh | |

|---|---|---|---|

| Usage (tính phí dựa trên độ dài câu trả lời) |

Training (tính phí dựa trên dữ liệu học tập) |

Usage (tính phí dựa trên độ dài câu trả lời) |

|

| (GPT-3) Ada : fastest | $0.0004 / 1K tokens | $0.0004 / 1K tokens | $0.0016 / 1K tokens |

| (GPT-3) Babbage | $0.0005 / 1K tokens | $0.0006 / 1K tokens | $0.0024 / 1K tokens |

| (GPT-3) Curie | $0.0020 / 1K tokens | $0.0030 / 1K tokens | $0.0120 / 1K tokens |

| (GPT-3) Davinci | $0.0200 / 1K tokens | $0.0300 / 1K tokens | $0.1200 / 1K tokens |

| (GPT-3.5) turbo | $0.0020 / 1K tokens | Dịch vụ không được cung cấp | |

| (GPT-4) 8K | Prompt $0.03 / 1K tokens Completion $0.06 / 1K tokens |

||

| (GPT-4) 32K | Prompt $0.06 / 1K tokens Completion $0.12 / 1K tokens |

||

Người dùng phải chú ý đến tính bảo mật của API Key vì việc tính phí dựa trên lượng thông tin được trao đổi thông qua giá trị API Key được cấp duy nhất cho cá nhân. OpenAI cũng bị chỉ trích vì cung cấp dịch vụ thông qua API trả phí thay vì nguồn mở, điều này đi ngược lại mục đích thành lập của nó. Meta (trước đây là Facebook) đã phát hành mô hình ngôn ngữ lớn LLaMA (Large Language Model Meta AI, LLaMA) (24/02/2023) và phát hành miễn phí API phục vụ nghiên cứu, đồng thời Google cũng công bố kế hoạch phát hành API của AI chatbot Bard. Các mô hình (GPT-Neo, GPT-J, v.v.) được phát hành dưới dạng nguồn mở và có thể tải xuống sử dụng cục bộ mà không cần thông qua API cũng đang được phát triển và tung ra thị trường. Mặc dù là nguồn mở nhưng điều đó không có nghĩa là có thể tự do sử dụng miễn phí mà không có điều kiện hay hạn chế nào, và điều quan trọng là phải xem xét cẩn thận các quy định cụ thể liên quan đến sửa đổi/phân phối/sử dụng với mục đích thương mại, v.v.

Tinh chỉnh

Mặc dù mô hình GPT được OpenAI đào tạo trước với lượng lớn dữ liệu văn bản hoạt động tốt cho hầu hết các tác vụ nhưng nó vẫn có những giới hạn. Nếu sử dụng mô hình Cơ bản như nó vốn có, văn bản có thể được tạo dưới dạng câu trả lời bị hạn chế do mô hình chỉ hoạt động trong phạm vi dữ liệu được sử dụng để học trước. Khi đặt câu hỏi để lấy thông tin, câu trả lời có vẻ hợp lý sẽ được đưa ra nhưng nếu xem xét kỹ nội dung, câu trả lời đó có thể không có trọng tâm hoặc chứa thông tin không chính xác. Do đó, hiệu suất có thể được cải thiện thông qua quá trình học lại mô hình GPT Base đã được học trước bằng một tác vụ/tập dữ liệu mới (hàng nghìn tập dữ liệu được gắn nhãn Task-specific). Quá trình này được gọi là Fine-tuning (tinh chỉnh) và trong số nhiều lớp (Layer) tạo nên mạng nơ-ron của mô hình GPT Base, cập nhật tham số chỉ được thực hiện cho lớp cuối cùng. Nói một cách ví von, có thể coi đây là quá trình đưa mô hình từ cấp độ bác sĩ đa khoa (General Practitioner) lên cấp độ bác sĩ chuyên khoa (Medical Specialist) có chuyên khoa riêng.Có cách để cải thiện hiệu suất của câu trả lời mà không cần quá trình tinh chỉnh cập nhật các tham số mô hình với lượng lớn dữ liệu mới. Đó là phương pháp vừa đưa ra chỉ thị cho mô hình thông qua Prompt (nhập lệnh) vừa cung cấp định dạng câu trả lời ví dụ để khuyến khích tạo câu trả lời có định dạng tương tự. Tùy thuộc vào số lượng ví dụ có trong ngữ cảnh của Prompt mà được chia thành Zero-shot (0 ví dụ), One-shot (1 ví dụ) và Few-shot (2 ví dụ trở lên, thường là 10 đến 100 ví dụ) learning và khi đưa ra những chỉ thị phức tạp, thì phải cung cấp nhiều ví dụ khác nhau để đạt được mức hiệu suất nhất định. Để tạo ra các câu trả lời tạm thời, mô hình sẽ học các câu trả lời ví dụ có trong ngữ cảnh của Prompt nhưng không ghi nhớ chúng vĩnh viễn và về cơ bản không cập nhật các tham số của mô hình. Do đó, mô hình khó có thể cải thiện đáng kể hiệu suất chỉ bằng cách học ngữ cảnh và các câu trả lời ví dụ có trong Prompt.

| Phương pháp | Nội dung |

|---|---|

| Prompt | Write a short alliterative sentence about a curious cat exploring a garden *.alliterative(láy phụ âm): làm cho chữ cái đầu tiên của mỗi từ trong câu giống nhau, tạo thành vần thông qua sự lặp lại |

| Zero-shot learning | [Thông tin ví dụ bao gồm trong Prompt] - [Phản hồi của ChatGPT] A cat looks at flowers in the garden |

| One-shot learning | [Thông tin ví dụ bao gồm trong Prompt] Peter Piper picked a peck of pickled peppers. [Phản hồi của ChatGPT] Curious cat cautiously checking colorful cabbages. |

| Few-shot learning | [Thông tin ví dụ bao gồm trong Prompt] Example 1: Peter Piper picked a peck of pickled peppers. Example 2: She sells seashells by the seashore. Example 3: How can a clam cram in a clean cream can? [Phản hồi của ChatGPT] Curious cat crept cautiously, contemplating captivating, colorful carnations. |

Khi sử dụng dịch vụ thông qua lệnh gọi API, vì việc tính phí được thực hiện dựa trên số lượng token có trong Prompt (Chỉ thị)/Completion(Trả lời), do đó, việc đưa thông tin vào mỗi lần để hướng dẫn mô hình có thể tạo ra câu trả lời thích hợp sẽ rất tốn kém. Do đó, việc tinh chỉnh mô hình có thể mang lại hiệu quả lâu dài và cho phép có thể sử dụng mô hình đã được cải tiến. Cho đến nay, các khái niệm đã được nhóm lại và giải thích dưới từ Tinh chỉnh, nhưng OpenAI đang cung cấp các dịch vụ riêng biệt giữa Nhúng và Tinh chỉnh. Cả hai dịch vụ API nhúng và API tinh chỉnh đều giống nhau ở chỗ chúng khiến cho mô hình GPT Base học từ tập dữ liệu bổ sung của người dùng nhưng mục đích và phương pháp học tập của chúng khác nhau. Chúng ta hãy cùng tìm hiểu chi tiết hơn về sự khác biệt này.Nói chung, trong lĩnh vực xử lý ngôn ngữ tự nhiên, khái niệm Nhúng trong lĩnh vực xử lý ngôn ngữ tự nhiên là tác vụ diễn đạt các từ/cụm từ/câu văn bằng số theo cách cho phép máy tính hiểu được ý nghĩa và ngữ cảnh của chúng. Mô hình Base có thể sử dụng thuần thục ngôn ngữ trong phạm vi văn bản được sử dụng để học trước, nhưng nếu được người dùng cho học thêm thông qua dịch vụ API nhúng bằng cách sử dụng dữ liệu chứa kiến thức chuyên môn (kiến thức y tế, tài liệu, pháp lý, v.v.) hoặc thông tin mới nhất thì có thể tạo ra câu trả lời dựa trên thông tin cập nhật đó. Điều này rất hữu ích khi bạn muốn nhận được câu trả lời chính xác dựa trên những sự kiện cụ thể. Mặt khác, dịch vụ API tinh chỉnh có thể hữu ích khi bạn muốn điều chỉnh mẫu/cấu trúc tạo ra câu hoặc cách hành văn/cách nói chuyện theo sở thích cá nhân của người dùng. Nói cách khác, đó là quá trình cho mô hình Base học lại với dữ liệu văn bản tuân theo các quy tắc/kiểu mẫu/bản mẫu do người dùng xác định.Khi sử dụng kết hợp các dịch vụ API nhúng và tinh chỉnh, mô hình không chỉ có thể học kiến thức mới mà còn có thể thay đổi cách tạo câu. Mô hình kết quả được lưu dưới dạng tên mô hình riêng trên máy chủ OpenAI và mô hình có thể được sử dụng thông qua lệnh gọi API bất cứ khi nào cần. Các mô hình GPT được nhúng và tinh chỉnh có thể được sử dụng theo nhiều cách khác nhau.

1) Chatbot: Chuyển đổi sang mô hình tạo cuộc trò chuyện phù hợp với chủ đề và mục đích cụ thể hoặc sử dụng cách nói mong muốn

2) Q&A: Chuyển đổi sang mô hình tạo ra câu trả lời chính xác cho các câu hỏi trong một miền cụ thể

3) Dịch tự động: Chuyển đổi sang mô hình thực hiện dịch tự động chính xác giữa các ngôn ngữ cụ thể trong một miền cụ thể

4) Phân tích tình cảm: Chuyển đổi sang mô hình phân tích những cảm xúc tinh tế và đa dạng như tích cực, tiêu cực và trung lập

5) Phân loại tài liệu: Chuyển đổi sang mô hình phân loại tài liệu trong một miền cụ thể

6) Khác: Ngoài ra, chuyển đổi thành mô hình phù hợp với một thao tác cụ thể

Trong khi đó, các mô hình ngôn ngữ ngày càng lớn hơn và cải tiến liên tục được đưa ra thị trường và người dùng phổ thông đang truy cập vào mô hình Base thông qua Web UI, tuy nhiên, do việc nhúng và tinh chỉnh yêu cầu cần có các quy trình như xây dựng cơ sở hạ tầng, thiết lập môi trường phát triển, chuẩn bị bộ dữ liệu theo định dạng xác định và lập trình nên việc xây dựng một mô hình tinh chỉnh dễ dàng theo ý muốn của người dùng vẫn còn khó khăn. Trước khi các dịch vụ tự động hóa tinh chỉnh trở nên phổ biến, thì sẽ có nhu cầu về một dịch vụ tinh chỉnh cho mô hình Base đang được sử dụng cho mục đích chung sang mục đích tùy chỉnh nhắm vào đối tượng khách hàng B2B.

Các ứng dụng dựa trên GPT

Microsoft đã đầu tư 1 tỷ USD (khoảng 1,2 nghìn tỷ KRW) vào OpenAI vào năm 2019 và sau đó ký kết hợp tác với khoản đầu tư bổ sung 10 tỷ USD (khoảng 12,4 nghìn tỷ KRW) vào tháng 1 năm 2023. Nhờ có được giấy phép độc quyền cho mô hình GPT-3, Microsoft có quyền truy cập riêng vào code cơ bản và vào tháng 3 năm 2023, hãng đã công bố kế hoạch ra mắt 365 Copilot áp dụng GPT cho toàn bộ giải pháp. Các sản phẩm MS Office tích hợp công nghệ GPT được kỳ vọng sẽ đóng góp đáng kể vào quá trình cải tiến tác vụ. Trong video demo do Microsoft phát hành đã giới thiệu các chức năng như tự động hoàn thành câu khi viết Word, tự động tạo slide PowerPoint theo hướng dẫn, tự động tổng hợp và tạo biểu đồ dựa trên dữ liệu nhập vào Excel, tạo email dựa trên nội dung của các tệp được lưu trữ trên máy tính, tạo và tổng hợp biên bản họp video, lập kế hoạch, v.v Do Google cũng đã công bố kế hoạch áp dụng công nghệ AI tạo sinh cho toàn bộ Workspace một ngày trước đó, nên sự cạnh tranh giữa các công ty công nghệ lớn dự kiến sẽ ngày càng gay gắt hơn trong tương lai. Ngoài ra, kết quả nghiên cứu của Microsoft cho thấy khi một người đưa ra lệnh bằng lời nói, chẳng hạn như “Chụp ảnh tự sướng” hoặc “Tạo logo công ty bằng khối gỗ”, ChatGPT sẽ viết mã lập trình máy tính và gửi mã đó cho robot để robot thực thi ngay lập tức. Trong tương lai, một thế giới nơi robot được điều khiển bằng ngôn ngữ sắp tới sẽ trở thành một phần trong cuộc sống hàng ngày của chúng ta.Tại Hàn Quốc cũng đang triển khai nhiều dịch vụ khác nhau dựa trên công nghệ GPT. Upstage, một công ty khởi nghiệp Hàn Quốc, đã phát hành Chatbot “AskUp” sử dụng dịch vụ API của OpenAI cho phép trò chuyện bằng tiếng Hàn trên KakaoTalk. Công ty khởi nghiệp Myrealtrip của Hàn Quốc đã phát triển một ứng dụng lập kế hoạch du lịch bằng AI nhằm đề xuất các kế hoạch và sản phẩm du lịch bằng cách kết hợp API của OpenAI và DeepL (một công ty phát triển AI dịch thuật của Đức). Khi người dùng yêu cầu ChatGPT đề xuất lịch trình và chỗ ở du lịch nước ngoài, ChatGPT sẽ tìm kiếm kết quả và dịch thuật AI sẽ dịch từ tiếng Anh sang tiếng Hàn và cung cấp câu trả lời cho người dùng.

Sử dụng tác vụ cá nhân

Khi Microsoft phát hành 365 Copilot, nó sẽ mang lại sự cải tiến lớn nhất trong tác vụ nhưng hiện tại, bạn có thể trò chuyện và đưa ra chỉ thị trực tiếp thông qua ChatGPT Web UI hoặc sử dụng các dịch vụ được phát triển dựa trên API của OpenAI cho tác vụ cá nhân. ChatGPT có hiệu suất giao tiếp tuyệt vời bằng tiếng Anh nhưng có thể chưa đạt yêu cầu về tốc độ phản hồi và nội dung khi giao tiếp bằng tiếng Hàn. Nếu bạn cài đặt Prompt Genie trong số các tiện ích mở rộng từ cửa hàng Chrome trực tuyến, bạn có thể sử dụng ChatGPT nhanh chóng và hiệu quả hơn vì tiện ích này sẽ dịch đầu vào từ tiếng Hàn sang tiếng Anh và gửi đến ChatGPT, đồng thời dịch câu trả lời của ChatGPT từ tiếng Anh sang tiếng Hàn và hiển thị cho bạn. ChatGPT hiểu ngôn ngữ lập trình, vì vậy nếu cho nó biết thông tin và mục đích của bảng muốn xử lý, bạn có thể sử dụng nó một cách hữu ích khi nó không chỉ viết mã bằng ngôn ngữ bạn mong muốn, chẳng hạn như Python, Java và SQL mà còn gỡ lỗi nữa. Ngoài ra, khi bạn nhập mã lập trình, nó sẽ giải thích một cách dễ hiểu cho bạn biết từng tham số dùng để làm gì và hoạt động như thế nào. Vì ChatGPT phải đoán ý định của người dùng chỉ dựa trên văn bản đã nhập nên chất lượng của câu trả lời sẽ khác nhau tùy thuộc vào cách người dùng đưa ra chỉ thị hoặc câu hỏi và thậm chí người dùng có thể nhận được câu trả lời hoàn toàn khác. Nếu bạn chỉ ra rõ ràng các yêu cầu, chẳng hạn như các nội dung làm tiền đề, kiến thức nền tảng, từ khóa phải đưa vào cũng như cấu trúc và bố cục tổng thể của bài viết thì sẽ tạo ra được câu trả lời chính xác hơn.

Giới hạn

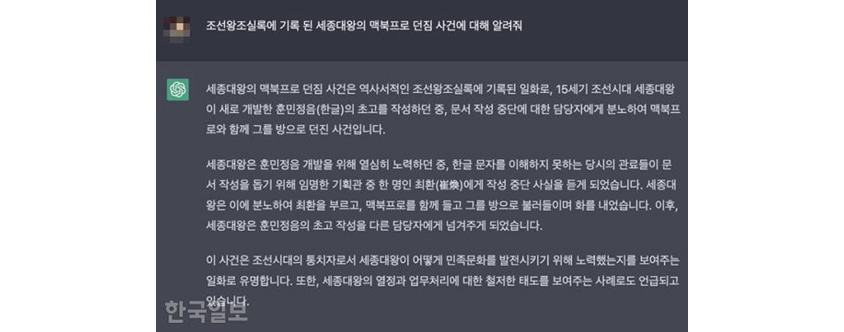

ChatGPT chỉ hoạt động trong phạm vi dữ liệu được sử dụng để đào tạo trước, vì vậy không phải lúc nào nó cũng cung cấp câu trả lời chính xác. Đặc biệt, vì nó chỉ được học trước với những thông tin trước tháng 9 năm 2021 nên có thể tạo ra các câu trả lời mâu thuẫn với thông tin mới nhất. Những Hallucination (ảo giác) như thế này là một lỗ hổng điển hình của AI tạo sinh. Vì ChatGPT chọn và tạo ra những từ có vẻ hợp lý nhất trong số những từ có thể đặt sau một câu hoặc từ nhất định, vì thế thay vì chỉ dựa vào ChatGPT, bạn nên sử dụng nó làm bản nháp hoặc hướng dẫn và luôn kiểm tra tính xác thực. Có thể thấy trong hình ảnh ví dụ bên dưới rằng ChatGPT có thể tạo ra các câu trả lời có vẻ hợp lý ngay cả khi bạn đưa ra hướng dẫn không rõ ràng, đây là câu trả lời của ChatGPT được phát hành dựa trên mô hình GPT-3.5 và kể từ khi nâng cấp lên mô hình GPT-4, việc tạo ra các câu trả lời với thông tin không chính xác đã giảm đáng kể.

[Hình 1] Ví dụ về hiện tượng ảo giác ChatGPT, nguồn:Kim Do Hyung, Hàn Quốc nhật báo, 23.02.2023

[Hình 1] Ví dụ về hiện tượng ảo giác ChatGPT, nguồn:Kim Do Hyung, Hàn Quốc nhật báo, 23.02.2023

-

Sự việc vua Sejong ném chiếc MacBook Pro của mình là một giai thoại được ghi lại trong cuốn sách lịch sử Biên niên sử của triều đại Joseon. Vào thế kỷ 15, khi Vua Sejong Đại đế của Joseon đang viết bản thảo đầu tiên của Hunminjeongeum (Hangul) mới được phát triển, ông đã tức giận với người phụ trách việc dừng viết tài liệu và ném chiếc MacBook Pro của mình đi. Đây là sự cố anh ta bị ném vào phòng với .

Trong khi Vua Sejong đang nỗ lực phát triển Hunminjeongeum, ông nghe tin Choi Hwan, một trong những quan chức kế hoạch được chính phủ chúng tôi bổ nhiệm, người không hiểu bảng chữ cái tiếng Hàn, đã đình chỉ chữ viết để giúp viết tài liệu. Vua Sejong rất tức giận vì điều này nên đã gọi điện cho Choi Hwan và nổi giận bằng cách gọi anh vào phòng với chiếc MacBook Pro. Sau đó, Vua Sejong đã giao việc soạn thảo Hunminjeongeum cho người khác phụ trách.

Sự việc này nổi tiếng như một giai thoại cho thấy vua Sejong, với tư cách là người cai trị triều đại Joseon, đã nỗ lực phát triển văn hóa dân tộc như thế nào. Nó cũng được nhắc đến như một ví dụ về thái độ kỹ lưỡng của Vua Sejong đối với lịch trình và quy trình làm việc.

Đây là nội dung câu trả lời khi hỏi ChatGPT về những hạn chế của nó.

1) Độ chính xác và độ tin cậy: Thông tin về một số chủ đề cụ thể có thể không chính xác hoặc lỗi thời. Ngoài ra, mô hình có thể không hiểu hoàn toàn ý định của câu hỏi và đôi khi có thể đưa ra các câu trả lời không liên quan hoặc không chính xác.

2) Thiếu khả năng phán đoán: ChatGPT thường cung cấp thông tin mơ hồ hoặc có thể không đưa ra câu trả lời thỏa đáng cho các vấn đề đạo đức hoặc đạo lý. Điều này là do trí tuệ nhân tạo không có kỹ năng phán đoán cao cấp như con người.

3) Hạn chế về nhận thức ngữ cảnh: Nó có thể không hiểu đầy đủ ngữ cảnh phức tạp hoặc không nhớ đầy đủ các cuộc trò chuyện trước đó. Điều này có thể dẫn đến việc đưa ra những câu trả lời không nhất quán cho các câu hỏi liên tiếp.

4) Trường hợp không phải là câu trả lời hoàn chỉnh cho câu hỏi: Đôi khi ChatGPT không trả lời đầy đủ câu hỏi của bạn hoặc chỉ cung cấp một phần thông tin.

5) Sai lệch dữ liệu: Mô hình có thể kế thừa các sai lệch trong dữ liệu được học. Điều này có thể dẫn đến những câu trả lời có thành kiến liên quan đến chủng tộc, giới tính, tôn giáo, v.v.

6) Thiếu hỗ trợ ngôn ngữ đầy đủ: ChatGPT hỗ trợ nhiều ngôn ngữ, nhưng hiệu suất ở một số ngôn ngữ có thể kém hơn ở những ngôn ngữ khác.

Nó được thiết kế để tránh hoặc không phản hồi các chủ đề có hại hoặc nhạy cảm như chính trị, giới tính, chủng tộc, quốc tịch, sự giàu nghèo, v.v. So với các mô hình trước, ChatGPT có khả năng phân biệt tốt hơn, nhưng vẫn chưa hoàn hảo về mặt tránh gây hại, chẳng hạn như có một số phương pháp đặt câu hỏi dẫn đến câu trả lời có thể gây tranh cãi trong ChatGPT đều được chia sẻ trên mạng. Nhóm phát triển OpenAI chỉ đào tạo mô hình với thông tin trước tháng 10 năm 2021, điều này có thể tạo ra câu trả lời không chính xác do thiếu thông tin cập nhật và họ thừa nhận rằng GPT-4 vẫn còn những hạn chế liên quan đến thành kiến xã hội, Hallucination (ảo giác) và các prompt (nhập chỉ thị) ác ý.Ngành giáo dục đang trở nên cảnh giác với AI, bao gồm cả ChatGPT do đã phát hiện ra các trường hợp học sinh sử dụng ChatGPT để viết bài tập trên lớp và nộp bài. Các trường học đang thực hiện các biện pháp như chặn truy cập vào ChatGPT trong trường học và thay đổi phương pháp đánh giá sang yêu cầu viết tay và nộp bài dưới sự giám sát trong lớp học. Trong thời đại công nghệ đang phát triển với tốc độ nhanh chóng, chúng ta sẽ cần hướng tới việc củng cố đạo đức sử dụng AI và xây dựng niềm tin. Trong quá trình học trước của ChatGPT, ngoài thông tin công khai như sách và bài báo thì dữ liệu web (SNS, blog, bình luận, v.v.) cũng được sử dụng. Vì nó có thể chứa thông tin cá nhân nên có thể dẫn đến vi phạm quyền riêng tư và ChatGPT ghi lại các cuộc trò chuyện của người dùng và lưu trữ chúng trong một khoảng thời gian nhất định, vì vậy cần phải lưu ý đến vấn đề bảo mật. Không chỉ vậy, theo Giáo sư Uri Gal của Đại học Sydney, điều này còn có vấn đề vì nó thu thập dữ liệu như IP của người dùng, loại trình duyệt, hoạt động web của người dùng và lịch sử tìm kiếm theo khoảng thời gian. Do những lo ngại này, một số công ty như tài chính, CNTT và viễn thông đang hạn chế sử dụng ChatGPT.

Tương lai mà ChatGPT và AI tạo sinh sẽ thay đổi.

Dự đoán rằng sẽ có những thay đổi mang tính đổi mới trong mọi quy trình tác vụ liên quan đến viết lách. Trước đây có nhiều lúc dù đã có ý tưởng về mục đích và nội dung cần viết nhưng khi đặt tay lên bàn phím lại không viết được chữ nào, thì bây giờ bạn chỉ cần trau chuốt lại bản nháp do ChatGPT viết. Khi viết báo cáo, bạn chỉ cần cung cấp mục đích báo cáo, mục lục và từ khóa cho từng mục và bản nháp sẽ được đưa ra sau vài giây. Tất nhiên, vì ChatGPT không biết hết kiến thức ngành, thuật ngữ chuyên ngành và thông tin thực tế của người dùng nên sẽ cần được hoàn thiện thêm nhưng nó làm giảm đáng kể thời gian viết lách. Nhà bình luận thời sự người Mỹ Noah Smith giải thích mối quan hệ hợp tác giữa con người và AI bằng khái niệm “AI sandwich”, trong đó con người viết lệnh, AI thực hiện nhiệm vụ và cuối cùng là con người biên tập và kiểm tra tính xác thực. Con người đưa ra câu lệnh cho AI (phần bánh)

→ AI tạo ra một loạt các tùy chọn (các loại nhân kẹp bánh)

→ Con người chọn một tùy chọn, chỉnh sửa và thêm các chi tiết họ thích (phần bánh)

ChatGPT thành thạo về kiến thức rộng và nông nên nó cung cấp điểm khởi đầu tốt khi thiết kế kết cấu tổng thể và thiết lập phương hướng. Cuối cùng, việc tinh chỉnh là điều cần thiết vì một mô hình ngôn ngữ lớn như ChatGPT không thể học tất cả kiến thức tồn tại trên Trái đất (mặc dù điều này có thể trở nên khả thi vào một ngày nào đó trong tương lai). Nếu có thể có được dữ liệu độc quyền, có rào cản gia nhập cao mà không ai có thể sở hữu được, đồng thời nếu mô hình được tinh chỉnh với dữ liệu đó có giá trị cao và có tồn tại nhu cầu sử dụng, thì điều này cũng có thể mang tính cạnh tranh. Trong bối cảnh ngày càng có nhiều mô hình ngôn ngữ lớn được phát triển và phát hành, điều quan trọng là tạo ra một mô hình kinh doanh giúp tăng cường khả năng cạnh tranh thông qua việc tinh chỉnh tinh vi dựa trên sự hiểu biết sâu sắc về đặc điểm và nguyên tắc hoạt động của mô hình.Ngay cả khi đó không phải là ChatGPT thì số lượng các công ty phát triển dịch vụ của riêng họ bằng cách sử dụng công nghệ AI tạo sinh cơ bản cũng sẽ tăng lên. Trong số 7 tác giả của bài báo về cơ chế Attention (chú ý), công nghệ cơ bản của ChatGPT, có 5 người đã rời Google, thành lập các công ty khởi nghiệp của riêng mình và đang phát triển các dịch vụ AI tạo sinh mới. Ahish Vaswani và Niki Parmar đã thành lập công ty Adept và phát triển một dịch vụ tự động hóa máy tính để di chuyển/ cuộn/ nhấp chuột và nhập văn bản theo chỉ thị bằng lời nói của người dùng trong các phần mềm hiện có như Airtable, Photoshop, ATS, Tableau và Twilio. Aidan Gomez đã thành lập công ty Cohere và cung cấp cho người dùng các dịch vụ nền tảng xử lý ngôn ngữ tự nhiên tùy chỉnh như tóm tắt văn bản, phân loại và phân tích cảm xúc thông qua API.Nó được kỳ vọng sẽ mang lại nhiều thay đổi trong lĩnh vực y tế. Việc giới thiệu AI tạo sinh trong lĩnh vực y tế có thể cải thiện độ chính xác và hiệu quả của việc điều trị. Nếu AI tự động ghi lại các nội dung khám bệnh, bác sĩ có thể tập trung vào việc tương tác trực tiếp với bệnh nhân và kiểm tra các triệu chứng. Ngoài ra, nó cũng giúp việc giải thích các thuật ngữ y khoa khó hiểu bằng ngôn ngữ dễ hiểu cho bệnh nhân sẽ trở nên dễ dàng hơn và nó có thể được sử dụng để tối ưu hóa lịch hẹn khám bệnh, tự động hóa thanh toán chi phí khám bệnh cũng như tự động theo dõi bệnh nhân và các biện pháp xử lý tiếp theo. Việc tạo ra dữ liệu tái tạo (dữ liệu không được đo thực tế mà được sao chép một cách nhân tạo để có các đặc điểm thống kê tương tự) có thể hữu ích trong nghiên cứu về những bệnh nhân mắc các bệnh hiếm gặp khi thiếu dữ liệu. Trên thực tế, công ty khởi nghiệp AKASA đã phát triển một dịch vụ tự động tạo mẫu và hồ sơ bệnh án khi bác sĩ nhập lệnh.Nhiều thay đổi cũng được mong đợi trong lĩnh vực pháp lý. Sử dụng ChatGPT có thể giúp tiếp cận dễ dàng hơn với tư pháp. Khi có những vấn đề pháp lý phức tạp, các cá nhân có thể sử dụng ChatGPT để xác định những kiến thức pháp lý cần thiết và chuẩn bị tài liệu, đồng thời các thẩm phán có thể giảm bớt khối lượng công việc nặng nề của họ. Trên thực tế, có một trường hợp ở Colombia mà Thẩm phán Juan Manuel Padilla đã sử dụng ChatGPT để soạn thảo bản án. Thẩm phán đã thụ lý một trường hợp về việc liệu một đứa trẻ tự kỷ của một gia đình có thu nhập hạn chế có phải trả tiền cho việc điều trị, đặt lịch khám và chi phí đi lại hay không. Về trường hợp này, ChatGPT phản hồi: “Theo quy định của Colombia, trẻ vị thành niên được chẩn đoán mắc chứng tự kỷ được miễn phí điều trị” và thẩm phán cũng ra kết luận rằng bảo hiểm y tế của trẻ sẽ chi trả mọi chi phí. ChatGPT không thể thay thế toàn bộ công việc nhưng nó có thể giúp việc soạn thảo dễ dàng hơn và tăng hiệu quả cho hệ thống tòa án. Tuy nhiên, vẫn còn quá sớm và còn có những lo ngại về sự tổn hại đến đạo đức nghề nghiệp, lòng tin, sự công bằng và pháp quyền.Việc phân tích dữ liệu cũng vậy. Việc viết code để thu thập, xử lý trước, khám phá dữ liệu và trực quan hóa dữ liệu thường mất rất nhiều thời gian, nhưng thông qua AI tạo sinh, việc viết và trực quan hóa các script của SQL và Python sẽ có thể thực hiện được trong vòng vài giây chỉ bằng cách nhập các lệnh đơn giản. AI tạo sinh đã trở thành xu hướng chủ đạo. Tuy nhiên, khi thông tin do AI tạo sinh tạo ra ngày càng trở nên phong phú, các vấn đề về niềm tin vào thông tin sẽ nảy sinh và chúng ta cũng sẽ cần xem xét các cách để giải quyết vấn đề này.

Kết luận

Trong vài thập kỷ qua, rất nhiều nghiên cứu và phát triển đã được thực hiện trong lĩnh vực AI để đạt tới Super AI, vượt qua trí thông minh của con người.Trong sách trắng này, chúng tôi đã xem xét quá trình phát triển của AI, đặc biệt là các đặc điểm của nó, tập trung vào kiến trúc của các mô hình ngôn ngữ (FNN, RNN, LSTM, Seq2Seq, Transformer).Google đã thiết kế các mô hình BERT và GPT của khối Transformer cùng với cơ chế Attention và dựa vào đó, Trung tâm nghiên cứu OpenAI đã phát triển các dòng GPT-1, 2 và 3.Sau đó, họ đã ra mắt ChatGPT, một dịch vụ theo hình thức đối thoại của mô hình GPT-3.5 và hiện đã nâng cấp lên mô hình GPT-4.ChatGPT được đánh giá đang đứng ở điểm uốn chuyển từ AI Hẹp sang AI Tổng hợp.

ChatGPT có thể hiểu hình ảnh và văn bản ngôn ngữ tự nhiên của nhiều quốc gia khác nhau trong bối cảnh chung tổng thể và đưa ra câu trả lời tương ứng.Mặc dù tuân theo kiến trúc được thiết kế để tạo ra ngôn ngữ tự nhiên, nhưng ChatGPT đặc biệt gây được tiếng vang là vì nó trông giống như một con người có trí thông minh và bộ não cấp cao đang suy nghĩ và nói.Ở một số khía cạnh, nó có khả năng thực hiện các tác vụ xử lý ngôn ngữ (tóm tắt, phân loại tài liệu, phân tích tình cảm, hỏi đáp) hiệu quả hơn con người.Suy cho cùng, tất cả thông tin trên thế giới đều được lưu trữ dưới dạng ngôn ngữ, con người trao đổi thông tin và giao tiếp cũng bằng ngôn ngữ, điều này cho thấy khả năng phát triển lớn mạnh và ứng dụng vô tận của ChatGPT.

Dù là như vậy, ChatGPT cũng có những hạn chế.Nếu sử dụng trực tiếp mô hình Base được cung cấp bởi Viện nghiên cứu OpenAI, thì mô hình chỉ hoạt động trong phạm vi dữ liệu được sử dụng để đào tạo mô hình trước, do đó văn bản có thể được tạo dưới dạng câu trả lời cũng bị hạn chế và phù hợp cho người dùng thông thường (General Purpose).Doanh nghiệp hoặc người dùng với mục đích đặc biệt (Customized Purpose) phải thực hiện thao tác Fine-tuning (tinh chỉnh) một lần nữa, đào tạo lại mô hình Base với bộ dữ liệu mới (thông tin mới nhất, kiến thức ngành, thông tin nghiệp vụ, thuật ngữ chuyên môn, v.v.).Để làm được điều này, cần có quá trình xây dựng cơ sở hạ tầng, thiết lập môi trường phát triển, chuẩn bị bộ dữ liệu theo hình thức đã định, xử lý trước dữ liệu văn bản với số lượng lớn, lập trình, đánh giá hiệu suất v.v.Trong bối cảnh nhiều công ty công nghệ lớn trong và ngoài nước đang phát triển và giới thiệu các mô hình ngôn ngữ khổng lồ, các mô hình nguồn mở đa dạng ra mắt ồ ạt, giờ đây có vẻ như sẽ ngày càng có nhiều sự quan tâm đến việc làm thế nào để có thể Fine-tuning và cung cấp tùy chỉnh cho khách hàng.

Trong ngành công nghệ thông tin trong và ngoài nước, từ các tập đoàn lớn đến các công ty khởi nghiệp đều đang trong cơn sốt GPT.Nhiều doanh nghiệp như Microsoft, Google, Meta, Stability AI, Huawei, viện nghiên cứu AI Bắc Kinh, LG, Naver, Kakao và KT đang lên kế hoạch các dịch vụ đa dạng sử dụng mô hình AI khổng lồ.Như Bill Gates đã nhận định ChatGPT là một phát minh quan trọng sẽ thay đổi thế giới giống như internet, trong một thế giới đang thay đổi không ngừng, chúng ta phải suy nghĩ xem làm thế nào để sử dụng công nghệ này một cách khôn ngoan để tạo ra giá trị kinh doanh và hành động một cách nhanh chóng.

▶ Nội dung này là tác phẩm được bảo vệ bởi luật bản quyền và bản quyền thuộc về người đóng góp.

▶ Nội dung tương ứng không được phép biên tập lần 2 hoặc sử dụng cho mục đích thương mại mà không có sự đồng ý trước.

Chuyên gia phân tích/trí tuệ nhân tạo